Лекция

Привет, сегодня поговорим про информационные характеристики источников непрерывных сообщений , обещаю рассказать все что знаю. Для того чтобы лучше понимать что такое информационные характеристики источников непрерывных сообщений , настоятельно рекомендую прочитать все из категории Теория информации и кодирования.

Тема 7. информационные характеристики источников непрерывных сообщений . Источники с максимальной энтропией. Максимальная пропускная способность канала связи с помехами.

Лекция 10.

10.1 Информационные характеристики источников непрерывных сообщений.

Рассмотрим вопросы, связанные с информативностью и соответствующими характеристиками при передаче непрерывных сообщений (непрерывных функций времени), и выясним, какие особенности имеются в этом случае.

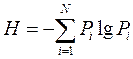

Основные информационные характеристики источников и каналов непрерывных сообщений определяются так же, как и для источников и каналов дискретных сообщений. Формулу для энтропии источника непрерывных сообщений получают путем предельного перехода из формулыдля энтропии дискретного источника.

<![if !vml]> <![endif]>

<![endif]>

Пусть одномерная плотность распределения вероятностей случайного стационарного процесса X(t) равняется W(x), тогда вероятность того, что X(t) будет находиться в интервале [xi, xi +∆x], равняется pi=W(xi)*∆x. Если сигнал квантован на L уровней, то энтропия источника непрерывных сообщений на один отсчет

|

<![if !vml]> |

В результате предельного перехода при ∆x→0получаем величину

|

<![if !vml]> |

которую называют дифференциальной энтропией источника непрерывных сообщений. Дифференциальной- потому что в ней участвует дифференциальный закон распределенияW(x).

Скорость передачи информации, пропускную способность и другие основные информационные характеристики источника сообщенийи канала передачи определяют через разницу дифференциальных энтропий.

Действительно, найдем, например, взаимную информацию между двумя непрерывными случайными процессами X(t) и Y(t) в произвольный момент времени t.

Считая, что

|

<![if !vml]> |

где W2(xi, yj) - совместимая плотность вероятности X и Y;

p(xi)=W1(xi)*∆x; p(yj)=W1(yj)*∆y ,

получаем выражение для взаимной информации между X и Y.

|

<![if !vml]> |

Применив для этого выражениясокращения, а после этого предельный переход, получаем

|

<![if !vml]> |

где h(X) и h(Y) - дифференциальные энтропии на отсчет случайных процессов X(t) и Y(t), а

|

<![if !vml]> |

-- условная дифференциальная энтропия отсчета Х(t) при известном отсчете Y(t).

И

|

<![if !vml]> |

- условная дифференциальная энтропия отсчета Y(t) при известном отсчете Х(t).

Таким образом, взаимная информация является конечной величиной. Об этом говорит сайт https://intellect.icu . Отметим, что дифференциальная энтропия не является абсолютной мерой собственной информации, она характеризует только ту часть энтропии непрерывного сообщения, которое определяется видом закона распределения вероятностей W(x). Найдем величину дифференциальной энтропии для конкретных законов распределений вероятностей.

10.2 Энтропия равномерного закона распределения.

Энтропия равномерного закона распределения. Для равномерного распределения W(x)=1/(b-a). По формуле для дифференциальной энтропии получаем

|

<![if !vml]> |

С увеличением интервала (b-a) значение h(X) также увеличивается.

10.3Энтропиягауссовогозаконараспределения.

Энтропия гауссового закона распределения. Найдем плотность вероятности стационарного случайного процесса X(t), с ограниченной средней мощностью, которая обеспечивает максимум h(X). другими словами, необходимо найти максимум функциив следующей постановке: задан целевой функционал:

<![if !vml]>

|

<![endif]>

<![if !vml]>

|

<![endif]>

и ограничения

Найти такую W(x), которая доставляет максимум энтропии h(X).

Решение этой задачи известно, и приводит к тому, что искомая плотность вероятности, удовлетворяющая условиям максимизации является гауссовой функцией

<![if !vml]>

|

<![endif]>

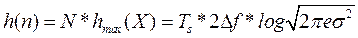

а максимальная энтропия

|

<![if !vml]> |

Следовательно, среди всех источников случайного сигнала с ограниченной и одинаковой средней мощностью (дисперсией) наибольшей энтропией владеет источник с гауссовским распределением сигнала.

На практике мы всегда имеем дело с сигналами (сообщениями и помехами) конечной длины и конечной энергии. При этом если продолжительность сигнала Ts, а его ширина спектра ∆f, то без потери информации такое непрерывное сообшение может быть представлено N=Ts*2∆f независимыми отсчетами . Таким образом для гаусового распределенияэнтропия отрезка непрерывного сообщения длительностью Tsбудет равна

<![if !vml]> <![endif]>

<![endif]>

10.3Контрольныевопросы.

1. Поясните относительность дифференциальной энтропии.

2. У какого закона распределения наибольшая энтропия при одинаковой дисперсии процесса?

Надеюсь, эта статья про информационные характеристики источников непрерывных сообщений , была вам полезна, счастья и удачи в ваших начинаниях! Надеюсь, что теперь ты понял что такое информационные характеристики источников непрерывных сообщений и для чего все это нужно, а если не понял, или есть замечания, то не стесняйся, пиши или спрашивай в комментариях, с удовольствием отвечу. Для того чтобы глубже понять настоятельно рекомендую изучить всю информацию из категории Теория информации и кодирования

Из статьи мы узнали кратко, но содержательно про информационные характеристики источников непрерывных сообщенийОтветы на вопросы для самопроверки пишите в комментариях, мы проверим, или же задавайте свой вопрос по данной теме.

Комментарии

Оставить комментарий

Теория информации и кодирования

Термины: Теория информации и кодирования