Лекция

Привет, сегодня поговорим про укажите google какие параметры url адресов игнорировать, обещаю рассказать все что знаю. Для того чтобы лучше понимать что такое укажите google какие параметры url адресов игнорировать , настоятельно рекомендую прочитать все из категории Интернет маркетинг , SEO, SMO, монетизация , .

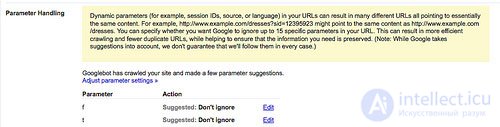

В "Google Webmaster Tools" в разделе Настройки сайта (Site Configuration Settings ) появилась новая функция. Это настройка, под названием "Управление параметрами" (Parameter Handling), позволяет владельцу сайта определить до 15 параметров которые робот Google будет игнорировать при индексации сайта.

Google составляет список параметров которые он нашел в URL адресах вашего сайта, который из них, по мнению поисковика является ненужным (с предложением "Игнорировать" или "Не игнорировать". Вы можете подтвердить или отменить эти предложения, или добавить параметры которых нет в списке.

Основное достоинство новой функции это то что она улучшает канонизацию сайта в индексе Google, защищая от проблемы дублированного контента. Проблема канонизации возникает когда по нескольким URL адресам загружается один и тот же контент.

Такая ситуация на вашем сайте может привести большому количеству негативных последствий (ну например, вы будете получать неточную аналитическую информацию), но с точки зрения поисковых систем, проблемы с канонизацией сайта это:

Существует много решений проблемы канонизации, в том числе несколько специально под Google, тогда зачем нужно было создавать для этого новую функцию в "Google Webmaster Tools"?

После того как поисковик Yahoo! добавил аналогичный инструмент в свой продукт для веб-мастеров "Site Explorer", в Google посыпались просьбы сделать что-то подобное и у себя (по крайней мере пока я работал в Webmaster Central часто приходилось читать такие сообщения).

Ниже я приведу различные способы канонизации URL адресов, и вкратце опишу их основные отличия.

Новая опция помогает решить проблему канонизации когда указаны дополнительные параметры адресов в паре "ключ — значение". Другими словами этот лист состоит из исключений (не индексируйте x,y и z параметров) а не лист включений (только индексируйте а и b).

Разве вы можете знать все возможные параметры адресов? Думаю, нет. Но иногда возникает проблема канонизации когда URL адрес вообще не содержит никаких параметров.

В идеале ваш сервер не должен быть настроен таким образом, но если такая конфигурация понадобилась ( например еще одна группа разработчиков или какая-то внешняя компания захотела что бы трекинг код был добавлен к адресу и изменены соответствующие настройки сервера), в таких ситуация вам лучше всего использовать "canonical" мета тег.

Две наиболее распространенные причины по которым устанавливают параметры и для которых эта функция будет очень хорошим решением это:

Самое большое преимущество это в увеличение эффективности индексации сайта ботом. Когда Google находит новый URL, перед индексацией они могут сверить параметры адресов с параметрами указанными в списке, если нужно убирают необязательные параметры и только после этого начинают индексацию (несмотря на это весь ссылочный вес передается на конечную страницу).

Это значительно снижает нагрузку на бота, и бот может проиндексировать больший объем сайта.

Еще одно достоинство что эта функция очень проста в использовании. Просмотрите список предложенных исключений и с помощью клика мышки выберите ненужные.

В некоторых компаниях может составлять определенные трудности редактирование кода страниц сайта, для того что бы вставить там где следует "canonical" мета тег, кроме того это отнимает лишнее время.

Чтобы использовать эту функцию даже не нужно обращаться за помощью к IT специалистам, это может легко сделать и обычный юзер, единственное что нужно это иметь доступ к Google инструментам веб-мастера (webmaster tools ).

Самый большой недостаток что эта опция работает только с поисковиком Google. Об этом говорит сайт https://intellect.icu . В прошлом, можно было использовать аналогичный инструмент и в другом поисковике - Yahoo! который был доступен в их наборе инструментов для веб-мастеров "Site Explorer".

В принципе этого было вполне достаточно. Но с появлением Microsoft Bing который вероятнее всего заменит индекс Yahoo и пока что Microsoft не предлагает ничего похожего вы можете ожидать, что 25%+ поисковой аудитории увидят неверную версию адреса вашего сайта.

Образно говоря, вы сами себе можете сделать подножку. Если случайно укажете для Google игнорировать какой-то очень важный параметр, если он не попадет в индекс, большая часть вашего сайта будет невидимой для поисковика.

Чем больше Google добавляет новых опций в свой набор инструментов для веб-мастеров, тем больше профессионализма требуется от того кто с этим будет работать, иначе могут быть очень плохие последствия.

На самом деле, Google предусмотрел и такую возможность, поэтому существует определенная защита от ошибок которые могут привести к плачевным последствиям для вашего сайта.

Это одна из причин по которой мы говорим "Если мы что-то захотели что бы Google делал, нет никакой гарантии что он будет это делать всегда". Но я думаю причина такой заботы в другом, они попросту не хотят что бы из-за каких-то тупых ошибок выпадали сайты из их индекса.

В отличии от случайной блокировки индексации с помощью файла robots.txt, в котором все прописанное поисковики воспринимают в приказном порядке, эта опция ( также как и много других) носит для поисковиков сигнальный характер.

Если уже существуют другие противоречащие "сигналы" (например, очень разнообразный контент), тогда вероятнее всего это действие не будет принято к исполнению.

Но даже зная, что Google использует такую систему защиты от ошибок, вряд ли кто-то захочет испытывать судьбу и наугад отключать параметры URL'ов, которые на первый взгляд могут показаться не очень важными (всегда помните о том что своими неправильными действиями вы можете причинить вред своему сайту).

Эта опция не будет работать если ваши проблемы канонизации не связаны с параметрами URL или если параметры не в стандартном формате пары "ключ — значение".

Мета тег "canonical" это еще один способ канонизации который действует на уровне страницы и указывает на каноническую версию страницы.

Он может быть очень полезным с точки зрения того что уже не имеет значения какие параметры URL адреса имеет страница, увидев на ней этот мета тег поисковик будет наверняка знать что эта именно страница является канонической.

Вы просто однажды указали какая страница должна быть канонической и уже не имеет значения какие параметры добавляются к URL адресу, поисковые машины всегда будут определять эту страницу как каноническую.

Как только этот мета тег появляется на странице, все поисковики: Google, Yahoo!, и Microsoft (по крайней мере они заявили о том что поддерживают канонический тег) обрабатывают ее как каноническую.

В отличии от соответствующей опции из "Google Webmaster Tools", перед тем как этот тег будет задействован поисковики должны сначала прочитать страницу, поэтому несколько теряется эффективность индексации.

Если поисковый бот попал на не каноническую страницу прочитав ее обнаружил этот тег, он начинает ее индексацию снова. Таким образом процесс индексации затягивается.

Как вы уже заметили использование этого способа, требует вносить изменения в код страницы, что не всегда возможно сделать в организации если нет в штате IT специалиста.

Как и со всеми остальными тегами, при прописывании этого тега в код страницы также можно допустить ошибку. Например, я обнаружил некоторые сайты в которых канонический тег который устанавливал для всех страниц канонической версией главную страницу сайта.

Как и выше описанную функцию из набора инструментов для веб-мастеров канонический тег как поисковики воспринимают в "рекомендационной форме", т.е. как не обязательный к исполнению, и если существуют другие признаки свидетельствующие о том что страница не каноническая то поисковики могут его проигнорировать.

Пожалуй Google больше остальных доверяет ему, и в большинстве случаев воспринимает канонической ту страницу на которую указал этот тег.

Наверное все согласиться с тем что самый лучший способ канонизации URL-адресов - это сделать 301 редирект всех "лишних" адресов на канонический адрес (естественно в идеале лучше не иметь других адресов страницы кроме канонического).

При использовании данного способа, все посетители а также роботы поисковиков перенаправляются на канонический адрес, и вместе с этим весь ссылочный вес также аккумулируется на нужной странице. В индекс попадает только одна каноническая страница.

Он понятен и обрабатывается всеми основными поисковыми системами. Также посетители остаются удовлетворенными (один URL для входа на страницу, для добавления в избранное, для отправки по e-mail и т.д.).

В большинстве случаев при использовании 301 редиректа поисковики консолидируют весь ссылочный вес на каноническом адресе.

Эта опция идеально подходит когда вы перемещаете контент (например, изменяете структуру URL адресов своего сайта или переезжаете на другой домен) также для того что бы указать поисковику какую версию домена индексировать, с www или без www.

Также не следует забывать что если вы делаете редирект на каноническую версию, то последующие ссылки вы получите именно на нее, потому что большинство посетителей попросту копируют то что у них в адресной строке браузера.

Когда вы используете параметры URL адресов для сортировки заказов или отслеживания покупок, редирект может попросту отключить их. Естественно вы можете настроить аналитическую программу для этих целей, но вряд ли это будет так просто сделать.

Еще одна проблема в том что не всегда умело используют редирект. Например, много веб-мастеров толи по незнанию то ли по ошибке используют 302 редирект (или еще хуже, редирект через JavaScript или мета обновление).

Или создают бесконечные цепи редиректов. В таких случаях роботы поисковиков перестают переходить по ссылкам внутри сайта и покидают его не проиндексировав ( если вы пользуетесь инструментами для веб-мастеров от Google и Microsoft, вы можете получить список URL'ов вашего сайта которые не проиндексировались из-за этого).

Еще одна темная сторона редиректа это то что он снижает эффективность индексации сайта ботом, особенно если существует цепь из нескольких редиректов.

В идеале бот должен переходить через все эти редиректы пока не проиндексирует конечную страницу, но если бот встречает ссылки на первоначальную версию адреса в индекс попадают обе версии (или даже больше, если страница меняла свой адрес несколько раз).

Эта опция позволяет сообщить для Google о том что вы собираетесь изменить домен. Но сначала нужно подтвердить ваши права обладания старым и новым доменами, и только затем вы сможете уже изменить все нужные настройки для такого перехода. Более подробную информацию как это правильно сделать читайте в разделе "Справка" на сайте Google..

Самым большим преимуществом этого инструмента перед другими способами канонизации является то что вы можете сообщить для Google о переходе вашего сайта с одного домена на другой. (очень распространенная проблема для тех кто имеет сайты на blogspot.com) Вы не можете воспользоваться 301 редиректом для перенаправления со старого домена на новый . Даже если вам и удалось каким-то способом сделать редирект между двумя доменами, нет ничего плохого в том что вы сообщите об этом Google!

Вы можете использовать эту опцию только при переходе с одного домена на другой. И также как и с другими инструментами с набора "Google webmaster tools" она работает только для поисковика Google.

Опция "предпочтительный домен" из "Google webmaster tools" позволяет сообщить Google о том хотите ли вы что бы ваш домен был проиндексирован с www субдоменом или без него. Если не сделать канонизацию сайта с www/не-www, тогда вы рискуете столкнуться с проблемой двойного контента.

По большому счету проблемы нет, поисковики корректно работают с такими сайтами (без канонизации). Но часто поисковики находят ссылки на обе версии сайта (с www, и без) и индексируют их отдельно друг от друга., в результате в индекс попадают как бы два отдельных сайта, со всеми вытекающими из этого последствиями.

Почему следует пользоваться этой опцией? Вы можете всегда использовать эту опцию, но также не забывайте делать 301 редирект между адресами с www, и без. Оба этих инструмента канонизации дополняют друг друга и между ними нет конфликта. Иногда Google самостоятельно применяет эту функцию в тех случаях где считает нужным.

Как и все остальные эта опция работает только для поисковика Google. И она не настолько эффективна как 301 редирект.

Наверное самый лучший способ борьбы с дублированным контентом, это заблокировать его в robots.txt ( или с помощью мета тега "robots"), тогда можно быть уверенным что проиндексируется каноническая версия сайта. Особенно актуально это для сайтов где есть страницы в версии "для печати".

Вообще говоря, с появлением мета тега "canonical" уже никакого. Ситуации при которых вы не захотите использовать редирект ( такие как наличие страниц "для печати") можно намного быстрее и проще решить используя "сanonical" тег. А проблемы индексации можно легко решить используя соответствующие функции в "Google webmaster tools" (естественно это актуально только для поисковика Google).

Основная проблема это потеря ссылочной массы. Ссылки на заблокированные страницы просто уходят в никуда, вместо того что бы перенаправляться на каноническую версию страницы, так как это делается в случае использования других опций.

Уже на протяжении длительного времени, Google самостоятельно пытается решить проблему канонизации, что бы в серпе оказались только канонические адреса страниц, даже если веб-мастера не предприняли никаких мер по канонизации.

Принцип такой, Google видит страницы з одинаковым контентом, автоматически определяет какая из них должна быть каноническая (это он делает по своим внутренним алгоритмам) и в СЕРПе появляется только та которая по мнению Google каноническая. Возможно они просто выбирают самый короткий URL адрес с наименьшим количеством включенных параметров.

C прошлого года Google информирует веб-мастеров в случае если обнаружения на сайте не канонические адреса о том что могут быть проблемы с индексацией. Очень похоже что Google имеет свой собственный список параметров которые нужно игнорировать.

Таким способом, инструмент настройки параметров подсказывает как Google воспринимает ваш сайт. Если вы видите в списке много параметров которые обозначены не на выбор, тогда следует проверить контент и URL которые используют эти параметры.

Проблема может быть даже глубже. Возможно на таких страницах Google не видит достаточно уникального контента (такое может случится, например, со страницами где много графики, много интегрированного контента, цифровые таблицы или списки, и т.д.). Вам следует сделать такие страницы более "уникальными". Разнообразив контентом.

К сожалению, в одной статье не просто дать все знания про укажите google какие параметры url адресов игнорировать. Но я - старался. Если ты проявишь интерес к раскрытию подробностей,я обязательно напишу продолжение! Надеюсь, что теперь ты понял что такое укажите google какие параметры url адресов игнорировать и для чего все это нужно, а если не понял, или есть замечания, то не стесняйся, пиши или спрашивай в комментариях, с удовольствием отвечу. Для того чтобы глубже понять настоятельно рекомендую изучить всю информацию из категории Интернет маркетинг , SEO, SMO, монетизация ,

Комментарии

Оставить комментарий

Интернет маркетинг , SEO, SMO, монетизация ,

Термины: Интернет маркетинг , SEO, SMO, монетизация ,