Лекция

Привет, Вы узнаете о том , что такое оценка информации в тексте, Разберем основные их виды и особенности использования. Еще будет много подробных примеров и описаний. Для того чтобы лучше понимать что такое оценка информации в тексте , настоятельно рекомендую прочитать все из категории Синергетика.

Предполагается проделать следующий опыт. На 32 карточках выписать все буквы русского алфавита. После тщательного перемешивания карт их извлекают наугад, записывают букву, возвращают карту в коробку, снова перемешивают, извлекают карту, записывают букву и т.д. Проделав такую процедуру 30-40 раз, получим набор букв. Математик Р. Добрушин в результате такого эксперимента получил набор букв, приведенный в первой строке табл. 1.

Таблица 1

Чередование букв беспорядочно, хаотично. Энтропия текста велика. По предложенной методике вероятность извлечения любой из букв одинакова, т. е.

Вероятность извлечения пустой карточки (промежуток между словами) также равна 1/32: на 32 буквы выпадает один интервал.

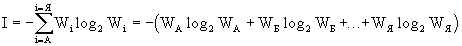

Энтропия появления каждой следующей буквы в тексте подсчитывается по формуле Шеннона

.

.Если вероятности появления букв одинаковы WА = WБ = ... Об этом говорит сайт https://intellect.icu . = WЯ, то получаем энтропию I~5 бит.

В реальных текстах частота появления каждой буквы и интервалы различны. В табл. 2 приведены частоты Wi букв в русском языке. Из-за неодинаковой вероятности появления различных букв в реальных текстах их энтропия меньше, чем в первом опыте. Во втором опыте в коробку помещается уже не 32 карточки, а больше: число карточек пропорционально вероятностям появления букв. Например, на 1 карточку с буквой Ф (WФ = 0,002) приходится 45 карточек с буквой О (WО = 0,090). Затем, как и в первом опыте, идет вытаскивание и возвращение карточек. В результате появляется фраза 2 (табл. 1), которая более упорядочена.

Таблица 2

Во-первых, из текста исчезли несуразно длинные слова.

Во-вторых, во фразе 2 гласные и согласные чередуются более равномерно, но, тем не менее, не все можно даже прочитать, не говоря уже о смысле.

Подставим в формулу Шеннона вероятность появления отдельных букв

Количество информации в сообщении, приходящейся на одну букву, уменьшилось, с 5 до 4,35 бит, т. к. мы располагаем сведениями о частотах встречаемости букв.

Но в языке существует частотный словарь, где учтены не только частоты отдельных букв, но и их сочетаний (парных, тройных и т. д.). Если учесть вероятность 4-х буквенных сочетаний в русском тексте, то получим фразу 3 (табл. 1).

По мере учета все более протяженных корреляций возрастает сходство полученных "текстов" с русским языком, но до смысла все еще далеко

Прочтение данной статьи про оценка информации в тексте позволяет сделать вывод о значимости данной информации для обеспечения качества и оптимальности процессов. Надеюсь, что теперь ты понял что такое оценка информации в тексте и для чего все это нужно, а если не понял, или есть замечания, то не стесняйся, пиши или спрашивай в комментариях, с удовольствием отвечу. Для того чтобы глубже понять настоятельно рекомендую изучить всю информацию из категории Синергетика

Из статьи мы узнали кратко, но содержательно про оценка информации в тексте

Комментарии

Оставить комментарий

Синергетика

Термины: Синергетика