Лекция

Это продолжение увлекательной статьи про физика информации.

...

наборе.

Формула Шеннона: I = — ( p1log2 p1 + p2 log2 p2 + . . . + pN log2 pN),

где pi — вероятность того, что именно i-е сообщение выделено в наборе из N

сообщений.

Легко заметить, что если вероятности p1, ..., pN равны, то каждая из них равна 1 / N, и

формула Шеннона превращается в формулу Хартли.

Помимо двух рассмотренных подходов к определению количества информации,

существуют и другие. Важно помнить, что любые теоретические результаты применимы лишь к определенному кругу случаев, очерченному первоначальными допущениями.

Пример 4. Факт получения информации субъектом об объекте есть выбор, приводящий к ограничению разнообразия и неопределенности состояний объекта, но только в гносеологическом смысле. Мы вправе полагать, что не только субъект, но и объект в информационном процессе познания осуществляет свой выбор в форме одного из возможных объектных состояний как информационно эквивалентную реакцию на выбор субъекта. Отличие объектного информационного выбора от субъектного усматривается нами в том, что первый не приводит к уменьшению разнообразия и неопределенности последующих объектных выборов, т.к. каждый из них – всего лишь ситуативная фиксация очередного выбранного состояния. Если представить состояния объекта как шары в урне, то опосредованный (виртуальный) выбор шаров эффективно познающим субъектом производится без возврата в урну, в то время как объект выбирает (предъявляет) их с возвратом. И это понятно – объект один, а субъектов, пытающихся его познать, много; если "шары" не возвращать в урну, на всех не хватит. Такой выбор есть не что иное, как генерирование копии "шара", т.е. копии состояния объекта.

Энтропия вычисляется через число возможных состояний источника и вероятности его перехода в эти состояния. Соответственно, количество информации, полученной от источника в результате опыта (акта познания), считается мерой неопределенности, снятой опытом – количество информации есть мера определенности опыта. Именно в таком смысле понимал энтропию и количество информации К.Э. Шеннон. Поскольку опыт уменьшает доопытную неопределенность, Шеннон предложил под количеством информации, полученным в опыте, понимать разность между априорным и апостериорным значениями энтропии4 . Отсюда следует, что энтропия и количество информации должны вычисляться в одних и тех же единицах для любого источника вне зависимости от содержания его состояний 5.

Определить для любого источника его состояния и их вероятности, по-видимому, можно лишь с известной степенью приближения и субъективизма6. Особенно трудно определить возможные состояния мыслящих источников информации, у которых эти состояния неподконтрольны. Для таких источников измерять информацию в понятиях энтропии и количества информации следует с осторожностью. Однако для нас главное – понять, что возможные состояния источника априорны, ибо не зависят от опыта, в то время как наблюдаемые в опыте состояния (события) апостериорны. Следовательно, об энтропии источника можно судить a priori и a posteriori, а о количестве информации – только a posteriori. Априорность энтропии и апостериорность количества информации позволяют сделать следующий вывод: априорная энтропия источника (если она поддается измерению) полностью, а апостериорная частично характеризуют количественно его внутреннюю информацию, апостериорное количество информации – внешнюю информацию источника.

Пример 5. Если полагать, что число состояний Универсума стремится к потенциальной бесконечности, то потенциальная энтропия Универсума как источника информации количественно тоже стремится к бесконечности. На фоне научно-философской полемики о пространственно-временной бесконечности или конечности Вселенной приведенное суждение позволяет утверждать, что если Вселенная и бесконечна, то прежде всего в информационном смысле. Трудность нашего положения обусловлена отсутствием экспериментальных или имитационно-вычислительных методов проверки информативности Вселенной как наиболее доказательных в рациональной науке. Попытка же абсолютного, полного познания источника с бесконечным числом состояний приводит к порочному кругу, внутри которого мы вынуждены вращаться бесконечно долго, задавая бесконечное число вопросов и получая на них столько же ответов, которые для своего хранения потребуют бесконечной памяти. Отсюда количество информации, получаемой в любом опыте, всегда конечно и не превышает энтропии источника – Универсума или любой входящей в него системы. Данные рассуждения имеют и строгую математическую основу (закон конечной информации).

Измерение информации традиционно связывается с кибернетическими системами (биологическими и искусственными). Однако нельзя отрицать, что кибернетические системы являются одновременно и физическими системами, раз они подчиняются общим физическим законам (в том числе, второму началу термодинамики) и состоят из тех же химических элементов (и отчасти веществ), что и неживая природа. Отсюда следует, что в кибернетической системе должна постоянно происходить борьба между порядком (управляемостью, несвободой, знанием, жизнью с ее неравновесностью) и хаосом (неуправляемостью, свободой, незнанием, смертью с ее равновесием). В этом плане необходимо более внимательно отнестись к взаимодействию эволюционного механизма со вторым началом термодинамики и взаимосвязи термодинамической и информационной энтропийных составляющих в рамках общей энтропии системы.

Пример 6. Неумолимая смерть биологических систем воочию свидетельствует о подобных связях и энтропийном дуализме природы каждой системы, общая энтропия которой содержит две составляющих – термодинамическую и информационную как операнды некоего уравнения, пока неизвестного математической физике. Относительно информационной энтропии теория информации утверждает, что в закрытой (замкнутой) системе, изолированной от окружающей среды, энтропия может изменяться в пределах от нуля (одно из состояний достоверно, остальные невозможны) до максимума, зависящего от числа состояний, когда их вероятности одинаковы. В той же системе термодинамическая энтропия никогда не уменьшается. В крайнем случае, она может оставаться постоянной и, соответственно, общая энтропия системы может возрастать, уменьшаться и оставаться постоянной, никогда не достигая нуля.

Приведенный пример – идеализация. Реальная биологическая система (как и любая система небиологического происхождения) проявляет себя в разное время и в разной степени как открытая и закрытая системы одновременно, ибо среда всегда в той или иной мере вносит возмущения в системы, невзирая на их классификацию, придуманную людьми. Закрытые системы независимы друг от друга. Но эта независимость, скорей всего, метафизична. Физична только зависимость систем, совместно обитающих в Универсуме, как зависимы все люди, обитающие на Земле. Информационная энтропия открытого зависимого источника (системы) условна в том смысле, что она определяется при условии известных состояний остальных влияющих источников (систем), входящих в среду обитания зависимого источника. В данном контексте условна и апостериорная энтропия как вычитаемый операнд выражения для количества информации, ибо наблюдатель (субъект, потребитель информации) и наблюдаемый объект (источник информации) в любом опыте взаимозависимы. Полная информационная независимость от среды (как вырожденный случай, когда энтропия становится безусловной) возможна при потере системой адаптации к среде, при подавляющих помехах в каналах связи и управления. Даже если такой вырожденный случай возможен, теплообмен между средой и системой (термодинамику) как одну из примитивнейших форм движения материи исключить невозможно, разве только при абсолютном нуле температур, который недостижим (согласно третьему началу термодинамики). В общем, в философии информации для термодинамики и теории информации открыто общее поле интересов.

Мы рассмотрели вероятностный подход к измерению информации. В современной информатике прикладное значение имеет измерение информации, циркулирующей в каналах связи и управления и хранимой на носителях информации. Для этого чаще используетсякомбинаторный (алфавитный) подход А.Н. Колмогорова, представляющий информацию в виде последовательности знаков и ориентированный на определение длины данной последовательности. Комбинаторная мера количественно ограничивает информационное разнообразие "сверху" числом возможных комбинаций. Там, где есть ограничение сверху, должны быть и механизмы ограничения снизу. Их несколько. Онтологически наиболее значимым является ограничение разнообразия снизу неделимостью информационного кванта, соответствующего двум состояниям (информативность – 1 бит). Меньше (одно состояние) – однообразие с нулевой информативностью. Можно возразить, что рассуждения о минимальной информативности кванта в один бит и неинформативности однообразия суть абстрактные суждения, исходящие из свойств логарифмической функции от аргумента – разнообразия по двоичному основанию логарифма 1 bit = log22. На самом деле логарифмическая мера информации вполне физична.

Пример 7. Психофизический закон Вебера – Фехнера постулирует интенсивность ощущения как величину, пропорциональную логарифмуинтенсивности физического раздражения. Время реакции на раздражения при числе раздражителей k пропорционально логарифму k. Что есть передача раздражения, как не информационный процесс? Что есть интенсивность ощущения, как не количество информации, полученное в этом процессе? Из теории поиска известно, что число шагов наиболее эффективного по быстродействию двоичного поиска в системе с равновероятными состояниями равно логарифму числа состояний (размера поискового пространства). Наконец, утверждение о нулевой информативности системы с одним известным состоянием (log 1 = 0) не противоречит интуиции здравого смысла, что также немаловажно.

И вероятностный, и комбинаторный подходы к измерению информации имеют отношение только к привычной внешней информации. Что касается количественных мер для измерения внутренней информации, то, по нашему мнению, они нецелесообразны (по крайней мере, в современной науке). Ведь внутренняя информация объекта как его семантическое образное содержание (смысл, концепт, самоотображение) – не число, не материя и не энергия. Рациональная установка физика Галилея (Галилео Галилей был одновременно и выдающимся философом (см. его "Диалог о двух главнейших системах мира – Птолемеевой и Коперниковой", "Беседы и математические доказательства, касающиеся двух новых отраслей науки"). ) сделать все неизмеряемое измеряемым представляется неприменимой для скрытых (объективных) смыслов, для субъективного понятия новизны информации и субъективных привносимых смыслов. Внешнюю (материально-энергетическую плюс идеальную) и внутреннюю (идеальную) формы информации "аршином общим не измерить": "идеальная информация не содержит в себе ничего, поддающегося измерению, следовательно, доступная измерению информация не может быть идеальной" (Н. Винер "Я – математик"). Используемая в современной теории информации мера – информационная энтропия источника информации – в большинстве случаев не более чем формальная дань галилеевской парадигме измеримости, математическая условность в интересах рациональных доказательств теории информации, и не более того. Поэтому информационная энтропия – всего лишь условная мера внутренней информации, не имеющая статуса истинной "меры".

Что касается информационного поля как возможного носителя внутренней информации, то измерять хранимую в нем информацию, как мы измеряем файлы, хранимые на материальных носителях, пока представляется столь же гипотетическим, сколь и существование самого информационного поля.

Будучи уверенными в существовании внешней информации об объекте и предполагая, что внутренняя информация объекта как сущность тоже "есть", согласимся, что вне зависимости от своей формы информация должна подчиняться некоторым законам, свойственным любым сущностям и существующим объектам природы. Последняя "не знает" о своих законах, как не знает ни науки, ни математики, используемых людьми для описания этих законов – изобретений человеческого ума. Полагаем, что природе свойственны закономерности, законосообразности вне зависимости от человека, а законы природы, тем более облеченные в математическую форму, являются продуктами человеческого разума (Согласно Н. Винеру "невозможно доказательство того, что природа подчинена законам…", но "…без веры, что природа подчинена законам, не может быть никакой науки".) .

Основными законами природы являются законы сохранения. Значит, должен существовать и закон сохранения информации. Данный закон еще не обрел подобающего ему статуса среди других законов сохранения, возможно, потому, что до сих пор не достигнуто взаимопонимание об атрибутивной информации, о месте информации в ряду философских и общенаучных категорий, об отношениях информационной и термодинамической форм энтропии. Но от этого закон сохранения информации представляется нам не менее значимым, являясь одним из фундаментальных законов мироздания.

Количественный закон сохранения информации, а точнее закон сохранения энтропии, имеет строгое теоретико-информационное доказательство в математической форме. В философии информации мы приведем его в вербальной форме: для замкнутой (закрытой) системы текущая сумма количества взаимной (внешней) информации между источником и потребителем и их совместной энтропии есть величина постоянная, равная сумме априорных энтропий источника и потребителя (Догадки о существовании такого закона высказывались, начиная с 60-х г.г. ХХ в., многими учеными и философами, полагавшими, что некоторая математическая композиция энтропии и количества информации (шума и информации) должна быть константой. Значение этой константы определено автором в 2000 г. в предположении, что априорные энтропии источника и потребителя можно измерить.) .

Сумма априорных энтропий источника и потребителя есть константа сохранения, не зависящая от интенсивности и энергетики информационного процесса между ними (внутренняя и внешняя формы информации инвариантны к своим носителям). Смысл константы сохранения в том, что в любом информационном процессе совместная внутренняя информация источника и потребителя неизменна. Сумма априорных энтропий может интерпретироваться как суммарное "количество априорного знания" источника и потребителя друг о друге. Напоминаем, что вопрос об измеримости энтропий и их суммы остается открытым, поэтому приведенная формулировка закона справедлива только в рамках рационально-материалистической философии с ее математическим дискурсом.

Если же внутренняя информация идеальна, а потому не измеряема, тогда количественный закон сохранения информации становитсякачественным законом с чисто философским подтекстом. А именно: неизмеряемая внутренняя информация, частично проявляясь в измеряемой внешней информации, остается неизменной в своей идеальной сущности.

Если информационный процесс имеет физическую (материально-энергетическую) природу, значит, в нем идеальная сущность информации проявляется в ее материальном существовании, и, следовательно, между философскими категориями материи и идеального – не пропасть (как уверяют материалисты), а мост. Этот мост существовал всегда, а закон сохранения информации просто лишний раз напомнил об этом своей идеальной константой сохранения.

Как показано выше, внутренняя информация физически не наблюдаема в опыте, как не наблюдаем физический вакуум – низшее энергетическое состояние квантовых полей. Значит, носитель (вернее, хранитель) информации в виде гипотетического информационного поля имеет неэнергетическую или, по крайней мере, субэнергетическую природу, а закон сохранения энергии к такому носителю если и применим, то с очень серьезными оговорками. Зато наверняка закон сохранения энергии не применим к "носимому" – трансцендентальной внутренней информации, которая вместе с внешней информацией подчиняется собственному закону сохранения – закону сохранения информации вне материально-энергетических представлений. Обычно материально-энергетические законы сохранения строго формулируются для закрытой (замкнутой, изолированной) системы. Но информация проявляется лишь во взаимодействии систем (минимум двух), частично являя внутреннюю информацию во внешней, и закон сохранения информации не может не считаться с обеими формами информации. Даже закрытая система в информационном аспекте представляется нам состоящей, как минимум, из двух открытых подсистем – подсистемы источника и подсистемы – потребителя информации . Таким образом, сумма априорных энтропий как гипотетическая количественная мера общей внутренней информации источника и потребителя является константой сохранения, инвариантной к интенсивности информационного метаболизма до тех пор, пока метаболизм не изменяет уровень самоорганизации одной или обеих подсистем – участниц информационного процесса. Количественно новый уровень самоорганизации подсистемы соответствует новому значению ее априорной энтропии. Значит, в динамике развития (или деградации) подсистем (источника и потребителя) информационная константа сохранения, не являющаяся физической мировой константой, будет изменяться вместе с изменением их внутренней информации. Правда, такое изменение представляется не перманентным, а скорее скачкообразным, соответствующим синергетическим представлениям о бифуркационных и полифуркационных процессах. Но в каждом информационном взаимодействии, соответствующем значению константы сохранения, достигнутому на очередном "скачке" самоорганизации, приведенный закон сохранения информации действует неукоснительно, а динамичная внешняя информация количественно не может превысить текущего значения минимальной из энтропий, которые входят в достигнутую константу сохранения.

Давайте же, пользуясь методом аналогий, распространим законы сохранения и на информационный план бытия, сформулировав, как гипотезу, закон сохранения информации: в замкнутой системе количество информации остается неизменным.

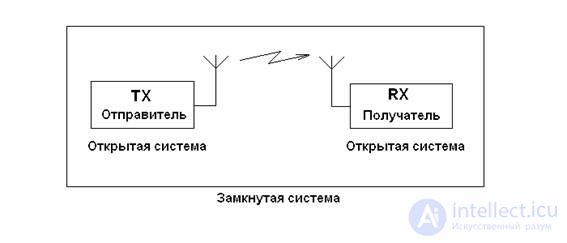

Правомочность гипотезы в науке принято проверять приложением ее к практике. Дело это нескорое и непростое, но некоторые примеры, как кажется, хорошо иллюстрируют сформулированный закон. Обратимся к близкому и родному — линии передачи информации (см. рисунок).

Оба корреспондента по отдельности, отправитель и получатель, являются, естественно, открытыми системами, поскольку передают и принимают информацию, т. е. взаимодействуют с окружением. Но оба они вместе есть система замкнутая, поскольку взаимодействие происходит внутри нее. Получатель, приняв сообщение, увеличил свою информацию. Если сообщение утеряно, забито шумом и помехами, то ничего страшного — у отправителя то оно осталось. Потому и придуманы протоколы обмена с переспросом, корректирующие коды и тому подобное. Заметим, что отправитель, отослав сообщение, количество своей информации не убавил! По-видимому, в информационном мире несколько иные правила, нежели в энергетическом и материальном. Сообщая информацию, вы ее не теряете, а получая — приобретаете ("научился сам — научи другого!"). Но с точки зрения всей замкнутой системы общее количество информации не убавилось, но и не прибавилось, ведь получатель принял то, что уже есть в системе, а заранее известное сообщение (по Шеннону) информации не добавляет. Хотя с узкой точки зрения получателя информации у него прибавилось. Тут, кажется, намечается и "принцип относительности" в информационном мире.

Осмыслив закон сохранения информации, получаем хорошо известный вывод: замкнутые подсистемы, внутри которых произошли уже все возможные передачи сообщений, развиваться и совершенствоваться не могут. Вспомните: "вариться в собственном соку", "загнивающий коллектив" и т. д. Главный принцип развития и совершенствования подсистемы — открытость, способность к обучению, в конечном итоге к обмену, т. е. к передаче и приему информации. Любая радиолюбительская связь — тому подтверждение.

Односторонний обмен, в частности, "работа только на прием", иногда тоже не спасает. Пример: за годы "железного занавеса" отечественная радиоэлектроника почти безнадежно отстала от мировой, хотя "работа на прием" шла во всю и "цельнотянутые" серии радиоламп, транзисторов и микросхем выпускаются до сих пор. Американцы не единожды, и даже в конгрессе поднимали вопрос, не наносит ли ущерб стране открытость публикаций в технических журналах и иных изданиях? Теперь, когда гонка технологий ими выиграна, ответ получен. Ущерба и не должно быть, ведь отдавая информацию, ее не теряешь. Конечно, есть и другие немаловажные причины нашего отставания. Не затрагивая общественно-политических, упомянем лишь закрытость, связанную с чрезмерной секретностью.

Не убывание информации при ее передаче широко используют в библиотеках, банках данных, справочниках. Вопрос хранения — особый. Можно ли утерять информацию? Для мелких подсистем — да. Люди забывают, библиотечные фонды списывают и уничтожают, магнитные ленты и диски стирают. Но стоит раздвинуть границы системы шире (см. рисунок), как мы видим, что в расширенной системе информация сохраняется. Забытый телефон можно переспросить, утерянные сведения — восстановить по первоисточникам и т. д. Широкий обмен способствует сохранению информации ("слово не воробей, поймают, и вылетишь!").

Здесь надо бы различить, перефразируя Иммануила Канта ("вещь в себе" и "вещь для нас"), понятия информации вообще, и информации, осмысленной нами. Последняя и приобретается и теряется, первая — нет. "Рукописи не горят". Разве законы тяготения не существовали задолго до Ньютона? И разве любое падающее яблоко не несло информацию о них? Просто Исаак Ньютон осмыслил их и представил в сжатой и понятной научному миру форме. В этом и состоит открытие. Индусы говорят больше: "каждый встреченный тобой человек — твой Великий Учитель".

Конечно, котенок, догрызающий рыбьи косточки на газетке с результатами выборов, политической информацией вовсе не интересуется, да и понять ее не может — для него этой информации как бы и нет, но ведь она есть! Не утихают споры о том, несут ли важнейшую информацию формы и размеры египетских пирамид, фигур в пустыне Наска, сооружений Стоунхеджа, древних наскальных изображений. Мы сейчас не решим этих вопросов, но подумать то есть над чем! Утерянную информацию восстанавливают, размывая иконы, читая берестяные грамоты, в конце концов, открывая заново. Расшифровали же письмена древних Майя!

Закончим эти заметки, добавив немного мистики, благоговейного ужаса и религии. Раз информация сохраняется, то "ничего нет тайного, что не стало бы явным". Не позавидуешь подлецам и преступникам: "Есть Божий суд, наперсники разврата!". Опыт показывает, что даже строжайшие тайны Второй Мировой теперь уже никакие не секреты, а пресловутую "Энгиму" современные шифровальщики считают детским лепетом. Если уж государственные тайны не сохраняются, что уж говорить о семейных и личных! Выходит, правы христиане, утверждающие, что есть Книга Бытия, где записана вся информация о любых наших поступках, хороших и плохих, и правы индуисты и буддисты, открывшие закон кармы, по которому любой поступок с неизбежностью вызывает соответствующее ему следствие. "По делам их судите их" — сказал Христос, а суд и воздаяние по заслугам рано или поздно осуществляются неотвратимо, поскольку действует во всей Вселенной закон сохранения информации.

Исчезновение информации в черной дыре — гипотетическое явление, которое должно происходить в черной дыре, если она действительно подчиняется термодинамическому описанию, предложенному Стивеном Хокингом. Это явление, однако, несовместимо с общими принципами квантовой механики и потому представляет собой серьезнейшую проблему, стоящую перед квантовой гравитацией.

Поскольку проблема состоит в том, что две физические теории противоречат друг другу, когда мы их пытаемся применить к черной дыре, в принципе не исключено, что одна из этих теорий просто перестает работать в данном случае. Так, например, высказывались мнения, что квантовая механика перестает работать в сверхсильных гравитационных полях. Другой вариант разрешения заключается в том, что излучение Хокинга, возможно, не совсем хаотично-тепловое, то есть между излучаемыми частицами могут быть некоторые корреляции, которые кодируют попавшую в черную дыру информацию. Таким образом, черная дыра не будет уничтожать информацию.

Пример 8. Замкнутая среда и зависимая от нее открытая система информационно взаимодействуют друг с другом, при этом информативность (энтропия) среды больше информативности системы, ибо последняя включена в среду, а не наоборот. Характер информационного взаимодействия системы со средой во многом зависит от целей системы. Если цель – самоорганизация, то ссинергетической точки зрения система приобретает информацию в количестве не более того, сколько может "переварить", использовать для своей самоорганизации, исходя из накопленного ею информационного разнообразия. Если же цель – самообучение, то с точки зрениякогнитологии и эпистемологии система познает то, что может, а если хочет познать больше, должна увеличить свои информационные возможности, т.е. потенциальную информативность своего тезауруса (базы знаний), свое информационное разнообразие. С позицийинформационного монизма информационное поле среды открыто системе лишь в меру возможностей восприятия внешней информации тезаурусом системы. Поскольку тезаурусы разных систем, входящих в среду, различны, системы воспринимают разную внешнюю информацию от среды даже в общем информационном процессе. Но и источник генерирует при этом количественно разную для всех информацию. Так, несколько наблюдателей некоторого объекта могут сделать на основе одного и того же наблюдения разные выводы, как из-за разной информативности своих тезаурусов, так и по причине разных "ответов" объекта на разные "вопросы" наблюдателей к одним и тем же результатам наблюдения. Разные социумы и разные индивиды недопонимают менталитет друг друга (и до конца не поймут!), потому что, вероятно, "взрыхляют" разные (в лучшем случае частично пересекающиеся) участки информационного поля. Таким образом, информационное разнообразие систем в Универсуме обусловлено в существенной мере разнообразием системных тезаурусов, селектирующих доступную им информацию в информационном поле Универсума в строгом соответствии с законом сохранения информации.

Важным следствием закона сохранения информации является жесткое количественное ограничение, накладываемое на информационный процесс достигнутой (текущей) информативностью его участников (источника и потребителя информации): их суммарная энтропия как количественная мера общей внутренней информации – константа, сохраняющаяся до следующего этапа развития (деградации).

Если считать при этом, что развитие систем как увеличение их организованности (порядка) связано с уменьшением энтропии, то каков предел такого уменьшения? Согласно теории информации энтропия в любой из своих форм не может быть отрицательной, ведь нуль-энтропия – это тупик развития (стопроцентная определенность). Термодинамический аналог – состояние физической системы при абсолютном нуле температур, соответствующем нулевой термодинамической энтропии, которая недостижима (третье начало термодинамики). Значит, потенциал развития систем всегда есть. Была бы нужда в науке, если все было бы познано? Возможно ли развитие общества, достигшего своего "последнего состояния"?

Кинетика количества внешней информации и потенциальность энтропии внутренней информации отличаются от превращения потенциальной энергии в кинетическую тем, что апостериорная условная энтропия не есть мера остатка априорной энтропии внутренней информации источника после генерации внешней информации, как это казалось бы при тривиальном энергетическом подходе. В отличие от энергии, которая "не есть", информация, которая "есть", не преобразуется из потенциальной внутренней формы в кинетическую внешнюю. Апостериорная энтропия количественно характеризует лишь апостериори недополученную (неотраженную, невоспринятую, непознанную) потребителем часть внутренней информации источника, измеряемой (?) посредством его априорной энтропии.

Таким образом, внутренняя информация не превращается во внешнюю, а лишь частично реплицируется (тиражируется, копируется) в нее; нереплицированная часть внутренней информации есть дефицит внешней информации (информдефицит), а количественно – часть энтропии (Напомним, что количественное измерение внутренней информации (подобно потенциальной энергии) представляется нам излишним. Сейчас трудно предсказать, как будет (и будет ли!) измеряться внутренняя информация в рамках грядущей информационной парадигмы и, соответственно, какой будет новая формулировка закона сохранения информации.) . Этим информационные процессы отличаются от материально-энергетических, где превращение имеет буквальный смысл – энергия нереплицируема. Кажущееся разрушение (уничтожение) внешней информации об объекте не разрушает внутренней информации объекта. Последняя лишь рассеивается и может быть восстановлена, чем, кстати, пользуются на практике (криптографическая защита, протоколы Интернета, сжатие файлов, компьютерные вирусы-невидимки, шумоподобные сигналы и др.).

Закон сохранения информации постулирует, как и следовало ожидать, что информация не возникает из "ничего". Не будь внутренней информации, внешняя информация не появлялась бы из "ничего". Закон сохранения информации можно было бы считать трюизмом, ибо всем сохраняемым величинам даны такие определения, что они должны сохраняться. В этом данный закон подобен любому закону сохранения (энергии, импульса, заряда и т.д.). Но парадокс в том, что законы сохранения, в основе которых лежат обычно самые простые и интуитивные представления, легче назвать трюизмами после того, как они доказаны, поняты и сформулированы, нежели до того. Возможно, в дальнейшем выявятся и другие законы взаимосвязи между свойством и отношением в феномене информации, уже не представляющиеся трюизмами.

Характерно, что закон сохранения и превращения энергии, постулирующий неизменность полной энергии изолированной системы, формально близок к рассмотренному закону сохранения информации. Не означает ли формальная близость двух законов их содержательного родства?

Прежде всего, содержательного родства нет между информацией и энергией. Ведь энергия в естествознании (как и масса, сила или длина) – всего лишь мера, придуманная людьми (по-древнегречески "энергия" – это действие, деятельность, а не некое количество). По-русски "естество – все, что есть" (В.И. Даль). Энергия-действие, энергия-деятельность как явления сущностей, которые "есть" и сами могут быть представлены как процессы (согласно принципу процесса Уайтхеда), могут исследоваться естествознанием как способность сущностей производить работу. А вот энергии-меры как естества "нет", она лишь используется естествознанием для различения естественных процессов по их интенсивности (в контексте информационного разнообразия "естества"). Поле тоже

продолжение следует...

Часть 1 2: Физика информации, Философия информации, Закон сохранения информации, Информационное поле, Измерение и измеримость информации

Часть 2 - 2: Физика информации, Философия информации, Закон сохранения информации, Информационное

Часть 3 Возможные варианты разрешения - 2: Физика информации, Философия информации, Закон

Часть 4 Принцип взаимной информации - 2: Физика информации, Философия информации, Закон

Категория информации по отраслям знаний

В информатике

В общественных науках

В физиологии и медицине

В других областях

Выводы из данной статьи про физика информации указывают на необходимость использования современных методов для оптимизации любых систем. Надеюсь, что теперь ты понял что такое физика информации, философия информации, закон сохранения информации, информационное поле, измеримость информации и для чего все это нужно, а если не понял, или есть замечания, то не стесняйся, пиши или спрашивай в комментариях, с удовольствием отвечу. Для того чтобы глубже понять настоятельно рекомендую изучить всю информацию из категории Философия

Ответы на вопросы для самопроверки пишите в комментариях, мы проверим, или же задавайте свой вопрос по данной теме.

Комментарии

Оставить комментарий

Философия

Термины: Философия