Лекция

Это продолжение увлекательной статьи про физика информации.

...

Утияме сильные (глюонные) внутриядерные взаимодействия осуществляются посредством некоммутативного калибровочного поля. Усилия физиков направлены сейчас на "суперобъединение" четырех известных типов взаимодействий (полей) в рамках единого многокомпонентного калибровочного поля – информационного А-поля, подчиняющегося единому фундаментальному принципу.

В качестве такого единого поля предлагается, например, физический вакуум (Г.И. Шипов. "Теория физического вакуума"), единым фундаментальным принципом которого является EGS-концепция его универсальных поляризационных (фазовых) состояний, проявляющихся на микро- и макроскопическом уровнях: в состоянии зарядовой поляризации физический вакуум проявляется как электромагнитное поле (E), в состоянии спиновой продольной поляризации – как гравитационное поле (G), в состоянии спиновой поперечной поляризации – как спиновое поле (S).

Теория полагает возможными и другие поляризационные состояния физического вакуума, а, следовательно, и другие поля. Но самый трудный вопрос – о физических носителях внутренней информации и волновых потенциалов полей. Утияма полагает, что эти носители имеют общую физическую природу, связанную со свойствами пространства.

Если физический вакуум (или некоторое его состояние) – информационное А-поле, то вектор свойств А, порождающий это поле, может быть отнесен только к одной субстанции – пространству, изотропно и однородно заполненному физическим вакуумом. Значит, информационное А-поле субстанционально редуцируемо (упрощаемо) только к субстанции – пространству и более ни к чему. Следовательно, информационное поле согласно концепции физического вакуума субстанционально предшествует другим полям и субстанциям – корпускулярно-вещественной форме материи (антиматерии), физическим полям, сознанию, но не пространству. В частности, что бы ни понималось под "духом" как метафизической субстанцией, он, "проницая все и вся" подобно эфиру, в мире физической материи должен иметь не менее вездесущего агента. На эту роль может претендовать только один агент – виртуальное информационное поле, которое, материализуясь во внешней информации, кооперирует физику смысла с метафизикой духа (вопреки научно философскому позитивизму).

В связи с изложенным представление о том, что в неживой природе нет структур, "специализирующихся" на отражательных процессах, подлежит пересмотру. Об этом говорит сайт https://intellect.icu . Спин элементарных частиц, корпускулярно-волновые пакеты, физический вакуум, виртуальные частицы, "квантовые точки" как локальные нано- и пикометрические "электронные ловушки" для микрочастиц – по-видимому, далеко не полный перечень таких структур, живо обсуждаемых в физических публикациях2 .

Пример 2. Дихотомический спин элементарных частиц полагается многими физиками физическим полевым переносчиком и хранителем двоичной информации, откуда следует рефлексивная гипотеза об онтологическом генезисе двоичного кода. Электронно-позитронный волновой пакет ("фитон") как элементарная квантово-полевая структура физического вакуума (с взаимно скомпенсированными спинами входящих в него частиц) полагается многими физиками как возможный виртуальный переносчик и хранитель информации в информационном поле, возбуждаемом при любой спиновой поляризации подобных пакетов. Квантовые точки – атомарные системы размером 10-9 м и менее – позволяют уже в обозримом будущем конструировать компьютерные логические элементы с использованием спина электрона, а также безэнергетического информационного процесса "квантовой телепортации".

Часть указанных в примере 2 структур и феноменов не наблюдаема, однако при определенных условиях содержащаяся в них информация проявляется в полях и сигналах, доступных нашим ощущениям и сознанию непосредственно или опосредованно через приборы3 . Так, ненаблюдаемая структура физического вакуума является средой наблюдаемого волнового распределения полевых потенциалов. Ненаблюдаемая информация, хранимая в недрах бессознательного (архетипы и др.) неведомыми (пока!) каналами связи передается в сознание (а из сознания в действие). Когерентные (синфазные) волны света несут ненаблюдаемую информацию, проявляющуюся в форме голограмм. Из когерентных спектральных составляющих радиосигналов можно извлечь информацию, "потерянную" в шумах. Если отрицать ненаблюдаемую внутреннюю информацию в косной природе, то логично отрицать ее существование и в геологических образованиях, хранящих наблюдаемые следы прошедших эпох, в палеонтологических и археологических находках, наконец, в книгах и на компьютерных дисках, хотя и созданных человеком, но все же "неживых". Если человечество за относительно короткий период своего существования сумело создать "неживую память", то можно ли безоговорочно утверждать, что прародительница природа за гораздо более длительный период своего развития не могла создать более емкую память для хранения своей внутренней информации?! Таким образом, физика вплотную подошла к представлению о ненаблюдаемой трансцендентальности как объективной реальности, к признанию этой трансцендентальности научной областью исследования. Здесь материализм встречается с идеализмом, не конфронтируя с ним по принципу "кто не с нами, тот против нас", а сотрудничая по принципу кота Леопольда: "Ребята, давайте жить дружно!". Полагаем, что такое сотрудничество удовлетворяет плюралистическим вызовам времени, чуждым черно-белого восприятия мира.

При всей дискуссионности обсуждаемых физических моделей философия по своему статусу не должна элиминировать (исключать) их из своей "базы проблем". Требуется непредвзятый методологически выверенный философский анализ. В частности, философ, "паря над схваткой", должен, как нам представляется, обращать пристальное внимание на два фактора: 1) степень изоморфности (сходства) выходных параметров моделей и соответствующих выводов; 2) степень независимости моделей по аппарату исследования, терминологии, первоисточникам, опытным данным.

Именно изоморфность и независимость (в указанном смысле) нескольких математических моделей развития и последствий глобальной ядерной войны дали одно из веских оснований ООН принять в свое время ряд известных судьбоносных ограничений на ядерные испытания и ядерные вооружения. Изоморфность и независимость многих исторически параллельных научных открытий и технических изобретений (исчисление бесконечно малых, законы сохранения материи и энергии, радио, самолет, электронный компьютер и др.) всегда давали немедленный толчок их развитию и практическому внедрению, в то время как уникальные достижения воспринимались с "восхищенным недоверием" и требовали неоднократного подтверждения (например, частная и общая теории относительности, рентгеновские лучи и др.).

Один из важных изоморфизмов трех независимых постнеклассических физических моделей вакуума и информационного поля (Вейник А.И., Шипов Г.И., Taylor R.), выявленный автором, состоит в их волновой ориентации. Согласимся, что корпускула ассоциируется, скорее, с физической материей как вещественным субстратом, а волна – с полем как более тонкой, почти виртуальной формой существования физической материи. Не сговариваясь, авторы всех трех моделей приходят к общим фундаментальным выводам:

Экспериментальные подтверждения: голография Д. Габора (скрытая информация, присутствующая в когерентных волнах поля, проявляется в голограмме!); оптимальные фильтры и "компрессоры сигнала" в технике связи и локации (скрытые в шумах сигналы, о которых наблюдатель даже не подозревает, становятся наблюдаемыми!).

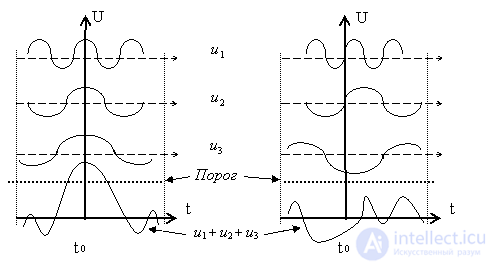

Пример 3. В радиотехнике оптимальная фильтрация сигнала часто производится путем синфазирования частотных составляющих сигнала, что вызывает так называемое "сжатие" сигнала и появление сжатого сигнального "пика" в определенный момент времени t0 над порогом обнаружения (рис.2.1.а: порог обнаружения "Порог"; частотные составляющие u1,u2,u3; сигнал u1+u2+u3). При малейшем сдвиге фаз относительно t0 пик сигнала рассыпается и может скрыться под порогом обнаружения (рис.2.1.б).

Техническая реализация оптимальных фильтров достаточно разнообразна. Для нас важно их общее свойство – подобие (т.е. совпадение с точностью до постоянных коэффициентов) информационных характеристик передаваемого сигнала и приемника этого сигнала. Такой приемник и есть оптимальный фильтр. Очевидно, что оптимальная фильтрация возможна при условии априорного знания приемником информационных характеристик ожидаемого сигнала (как минимум, его частотного спектра). Оптимальная фильтрация, доведенная до схемотехнических решений, материализует философскую суть эффективного познания объекта: субъект должен уподобиться объекту, чтобы эффективно познать последний.

Сосредоточение мысли субъекта на объекте познания, по нашему мнению, есть процесс именно такого уподобления, самонастройки интеллектуального приемника субъекта на режим оптимальной фильтрации сигналов познания, передаваемых объектом. Важно, что для адекватного уподобления объекту познания субъект должен априори, если не знать, то, по крайней мере, представлять латентные познаваемые свойства объекта. Следовательно, для эффективного познания субъект априори должен иметь теорию объекта, чтобы настроить свои средства познания (чувства, приборы, мозг) на режим оптимальной фильтрации сигналов, несущих внешнюю информацию об объекте: "решая задачу, знай ответ" (математика), "нужная информация – тому, кто ее ожидает" (ученые, экстрасенсы), "каждый видит (слышит) то, что хочет видеть (слышать)" (мистические практики познания: йога, буддизм, дзэн, исихазм и др.).

Если техника, созданная человеком, демонстрирует такие возможности, может быть, и сам человек способен извлекать латентную информацию за счет самонастройки мозга и всего тела (мыслит весь организм!) на прием волн информационного поля. Так, голографический способ записи и воспроизведения изображений полагается многими биологами и физиологами основой объемности механизма зрения. Не объясняет ли понятие информационного поля природу априорного знания ( "Знание как высшая форма информации"), кантовского "чистого разума"?

И тем не менее указанные модели мы относим к девиантной науке, ибо в рамках господствующей физической парадигмы мироздания им пока не находится места.

Если информация – физическая сущность, она должна согласно рациональной научно-философской доктрине поддаваться измерению. Первые методы измерения информации были предложены в начале ХХ в. (Р.А. Фишер, Р. Хартли). Продолжая начатое, Н. Винер в "Кибернетике" (1948 г.) оперировал математическими понятиями "количество информации" и "энтропия", которые в том же 1948 г. независимо от Винера использовал и К.Э. Шеннон, конституировавший теорию информации как математическую теорию связи. Заметим, что энтропия Винера – Шеннона – это информационная энтропия, в отличие от термодинамической энтропии Больцмана – Максвелла – Клаузиуса. Последняя исторически предшествовала понятию информационной энтропии. Лингвистическое совпадение этих понятий не случайно – за ним стоят важные содержательное и математическое совпадения, ибо в обоих случаях энтропия характеризует степень разнообразия состояний системы (источника информации, физической или иной системы).

Для теории информации важно сопоставить математические понятия информационной энтропии (далее просто энтропии) и количества информации. В рамках вероятностного (содержательного) подхода энтропию принято считать мерой неопределенности случайного выбора источником того или иного своего состояния. Любой подобный выбор, приводящий к ограничению разнообразия и неопределенности состояний источника информации, уменьшает его энтропию, увеличивая при этом количество информации как меру определенности выбора. Выбор, хоть и делается источником, принуждается (навязывается) потребителем информации, управляется этим потребителем, познающим источник.

Вопрос «как измерить информацию?» очень непростой. Ответ на него зависит от того, что понимать под информацией. Но поскольку определять информацию можно по-разному, то и способы измерения могут быть разными. Существует три подхода к измерению количества информации. При этом разные подходы к измерению информации применяются в быту, технике и в теории информации.

Измерение информации в быту

Предположим, что Вы получили какое-то сообщение. ( например прочитали статью в любимом журнале). В этом сообщение содержится какое-то количество информации. Как оценить какое количество информаци вы получили? Другими словами, как измерить информацию?

Можно ли сказать , что чем больше статья, тем больше информации она содержит? Разные люди, получившие одно и то же сообщение по разному оценивают количество информации, содержащееся в нем. Это происходит оттого, что знания людей об этих событиях , явлениях до получения сообщения были различны. Поэтому те, кто знал об этом мало, сочтут, что получили много информации, те же, кто знал больше, чем написано в статье, скажут, что не получили информации вообще. Таким образом можно сказать , что количество информации зависит от того насколько новой является эта информация для получателя .

При таком подходе непонятно, по каким критериям можно ввести единицу измерения информации. Следовательно, с точки зрения информации как новизны мы не можем оценить количество информации, содержащейся в научном открытии, новой теории общественого развития.

Измерение информации в технике

В технике информацией считается любая хранящаяся , обрабатываемая или передаваемая последовательность символов. Часто используют простой и грубый способ определения количества информации, который может быть назван обьемным. Он основан на подсчете количества символов в сообщении, т. е. связан с его длиной и не учитывает содержания.

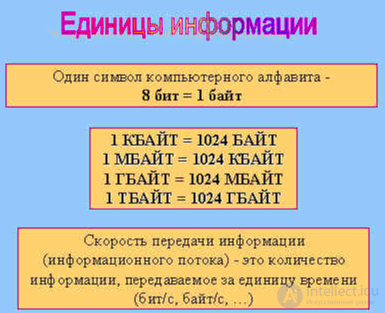

Длина сообщения зависит от числа различных символов, употребляемых для записи сообщения. В вычислительной технике применяются две стандартные единицы измерения: бит ( двоичный знак двоичного алфавита {0,1}) - минимальная единица измерения информации и байт - (равен восьми битам, представляет собой один символ, т.е. при вводе с клавиатуры этого символа машине передается 1 байт информации).

Измерение информации в теории информации (информация, как снятая неопределенность).

Пылкий влюбленный, находясь в разлуке, с обьектом своей любви, посылает телеграмму; “Любишь?”. В ответ приходит не менее лаконичная телеграмма: “Да!”. Сколько информации несет ответная телеграмма? Альтернатив здесь две- либо “Да”, либо “нет”.Их можно обозначить знаками двоичного кода - 1 и 0. Таким образом, ответную телеграмму можно было бы закодировать всего одним двоичным символом. содержащееся Можно ли сказать, что ответная телеграмма несет одну единицу информации? Получение информации ( ее увеличение ) одновременно означает увеличение знания или уменьшение информационной неопределенности.

Книга лежит на одной из двух полок - верхней или нижней. Сообщение о том, что книга лежит на верхней полке уменьшает неопределенность в два раза.

В простейшем случае выбор одного из двух сообщений ("да" или "нет", 0 или 1) принимают за единицу информации. Она названа "бит" или двоичная цифра. Вопрос ценности этой информации для получателя - это уже из иной области.

Сообщение о том, как упала монета- "орлом" или "решкой" несет один бит информации.

Известно, что Иванов живет на улице Весенней. Сообщение о том, что номер его дома четный, уменьшило неопределенность вдвое, мы стали знать больше, но информационная неопределенность осталась. Почему в этом случае мы не можем сказать, что информационная неопределенность уменьшилась вдвое? Если вы затрудняетесь ответить на этот вопрос, представьте себе улицу, на четной стороне которой, например, четыре дома, а на нечетной - двадцать. Такие улицы не такая уж большая редкость.

Очень приближенно можно сказать, что количество информации в сообщении о каком-то событии совпадает с количеством вопросов, которые необходимо задать, чтобы получить ту же информацию, ответ на эти вопросы может быть лишь "да" или "нет".

В теории информации количеством информации называют числовую характеристику сигнала, не зависящую от его формы и содержания и характеризующую неопределенность, которая исчезает после получения сообщения в виде данного сигнала. В этом случае количество информации зависит от вероятности получения сообщения о том или ином событии.

Для абсолютно достоверного события (событие обязательно произойдет, поэтому его вероятность равна 1) количество вероятности в сообщении о нем равно 0. Чем невероятнее событие, тем большую информацию о нем несет сообщение. Лишь при равновероятных ответах ответ "да" или "нет" несет 1 бит информации.

Оценка информации, так же как вещества или энергии, может быть субъективной и объективной. В первом случае главное - смысл информации, а во втором - ее измеримость.

Смысл информации для машины, обрабатывающей ее - это абсурд. Субъективная оценка информации не является универсальной.

При объективной оценке информации следует отрешиться от содержания ее человеческой "важности" для кого бы то ни было. Измеримость информации достигается использованием искусственных органов чувств - устройств, приборов, датчиков и т. д. Они не только расширяют пределы слышимого и видимого, но и могут обрабатывать сигналы, не доступные органам чувств человека.

Информацию измеряют так же, как измеряют вещество и энергию, приняв некоторую единицу измерения за эталон. Что же принять за эталон? Компьютерная техника, как известно, работает, “питаясь” электрическим током – явлением с двумя состояниями. Если обозначить эти состояния (ведь смысл самого явления не важен!), получится алфавит из двух символов или двоичный алфавит.

Количество информации, которое содержит символ двоичного алфавита, принято за единицу измерения информации.

Так как речь идет о единицах и количестве, то в качестве символов используются цифры. Исторически случилось так, что этими цифрами стали 0 и 1.

Единица измерения количества информации называется БИТ (от англ. bit, сокращенно от binary digit – двоичная цифра).

Бит - самое короткое слово двоичного алфавита и самая маленькая единица измерения информации, причем символы 0 и 1 равноправны. Для удобства введена более крупная единица измерения количества информации, принятая Международной системой СИ за основную, - БАЙТ (англ. byte).

1 байт (b) = 8 бит

Производные единицы измерения информации:

Первый способ измерения информации отражает вероятностный (содержательный) подход. Этот метод называется субъективным

Информация - сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределенности, неполноты знаний.

Точнее раскрыть суть определения помогает понять то, какие задачи помогает решить информация (а не то, что собой она представляет).

Информация устраняет неопределенность, предоставляет человеку сделать выбор в пользу какого-либо варианта исхода некоторого события. Таким образом, информация начинает играть роль в том случае, если, во-первых, имеется некоторый выбор вариантов и, во-вторых, если эти варианты требуется определенным способом оценить. Информация предоставляет человеку возможность дать такую оценку.

Рассмотрим равновероятностные варианты.

Подойдя к развилке дорог, человек, направляющийся в определенное место, неожиданно встает перед выбором, на какую же из них свернуть. Он выбирает ту дорогу, которая ведет к цели. Если он знает, по какой из дорог он доберется до места, то информация ему не нужна. С самого начала он способен оценить оба варианта. Если же вся обстановка совершенно незнакома и у него нет никаких исходных данных, то ему нужна информация. Объем информации, требующейся при полном отсутствии предварительных данных для выбора одного из двух равноценных и совершенно независимых вариантов, принято считать единицей информации и обозначать, как бит.

1 бит - количество информации, позволяющее выбрать один вариант из двух равноценных, независимых вариантов.

Чтобы иметь возможность сделать правильный выбор между четырьмя различными дорогами, требуется два бита информации. Поясним это на таком примере. Сначала две дороги делят на две группы по две дороги в каждой. Далее выбираем группу как один из двух равноценных вариантов, т. е. нам требуется один бит информации, После того, как будет выбрана группа, в ней опять делается выбор между двумя дорогами и нам требуется еще один бит. В сумме получаем два бита информации для выбора одного из четырех вариантов.

Если бы нам потребовалось сделать выбор из восьми вариантов, то нужно было бы три бита информации: один бит идет на выбор между двумя группами из четырех дорог, второй - в группе из четырех выбираем подгруппу, состоящую из двух дорог, третий бит - выбираем из двух дорог ту, по которой пойдем.

Для выбора одного варианта из 16 требуется четыре бита информации и т.д. Здесь уже прослеживается определенная закономерность: при n битах информации нужный вариант выбирается из 2n возможных.

И наоборот, указав один нужный вариант из 2n возможных и одинаково принимаемых в расчет, мы дадим информацию в n битов.

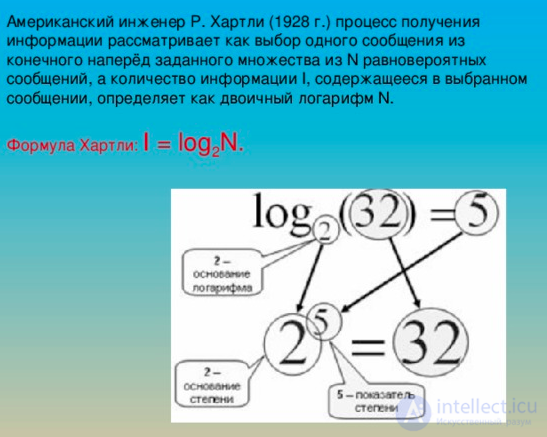

Количество информации n, содержащееся в сообщении о том, что произошло одно из N равновероятных событий, определяется из решения показательного уравнения: 2^n = N = > i = log2N (формула Хартли ).

Если события имеют разные вероятности, то применяется формула Шеннона, имеющая вид i= - Σ Pi log2 Pi = -(P1 log2 P1+ P2 log2 P 2 + ... + Pn log2 Pn), где i – количество информации, N – количество возможных событий, Pi – вероятность этих событий.

Тем самым мы получаем точное правило для определения объема информации, содержащейся в сведениях и сообщениях.

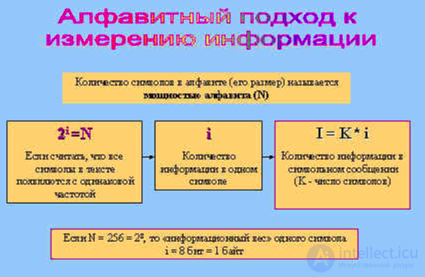

Алфавитный подход к измерению информации позволяет определить количество информации, заключенной в тексте. Алфавитный подход является объективным, т.е. он не зависит от субъекта (человека), воспринимающего текст.

Множество символов, используемых при записи текста, называется алфавитом. Полное количество символов в алфавите называется мощностью (размером) алфавита. Будем обозначать эту величину буквой N. Например, мощность алфавита из русских букв и дополнительных символов равна 54.

Представьте себе, что текст к вам поступает последовательно, по одному знаку, словно бумажная ленточка, выползающая из телеграфного аппарата. Предположим, что каждый появляющийся на ленте символ с одинаковой вероятностью может быть любым символом алфавита. (В действительности это не совсем так, но для упрощения примем такое предположение.)

Вот сколько информации несет один символ в русском тексте! А теперь для того, чтобы найти количество информации во всем тексте, нужно посчитать число символов в нем и умножить на i.

Возьмем с книжной полки какую-нибудь книгу и посчитаем количество информации на одной ее странице. Пусть страница содержит 50 строк. В каждой строке — 60 символов. Значит, на странице умещается 50*60 = 3000 знаков. Тогда объем информации будет равен: 5,755 х 3000 = 17265 бит.

Следовательно, при алфавитном подходе к измерению информации количество информации от содержания не зависит. Количество информации зависит от объема текста (то есть от числа знаков в тексте) и от мощности алфавита.

Отсюда следует, например, что нельзя сравнивать информационные объемы текстов, написанных на разных языках, только по объему. У них отличаются информационные веса одного символа, так как мощности алфавитов разных языков - различные.

В каждой очередной позиции текста может появиться любой из N символов. Каждый символ несет i бит информации; число i можно определить из уравнения:

2*i = N. Для N = 54, используя таблицу, получаем: i = 5,755 бит.

Но если книги написаны на одном языке, то понятно, что в толстой книге информации больше, чем в тонкой. При этом содержательная сторона книги в расчет не берется.

Сформулируем правило, как измерить информацию, используя для этого алфавитный подход.

Количество информации, содержащееся в символьном сообщении, равно К*i, где К— число символов в тексте сообщения, a i -информационный вес символа, который находится из уравнения 2^i = N , где N — мощность используемого алфавита.

Множество символов, используемых при записи текста, называется алфавитом. Полное количество символов в алфавите называется мощностью (размером) алфавита. Если допустить, что все символы алфавита встречаются в тексте с одинаковой частотой (равновероятно), то количество информации, которое несет каждый символ, вычисляется по формуле: i = log2N.

Применение алфавитного подхода удобно, прежде всего, при использовании технических средств работы с информацией. В этом случае теряют смысл понятия «новые - старые», «понятные - непонятные» сведения. Алфавитный подход является объективным способом измерения информации в отличие от субъективного, содержательного, подхода.

Прагматический подход к измерению информации позволяет определить количество новой информации по отношению ко всей. Прагматический подход - оценивается полезность сообщения

Однако, при таком подходе непонятно, по каким критериям можно ввести единицу измерения информации. Следовательно, с точки зрения информации как новизны мы не можем оценить количество информации, содержащейся в научном открытии, новой теории общественного развития.

Прагматический подход - оценивается полезность сообщения. I=log 2 (P1/P0), где P - вероятность решения задачи P0 до сообщения и P1 после сообщения.

Внешняя память компьютера используется для длительного хранения информации.

Устройства внешней памяти: магнитные диски и ленты, оптические (лазерные) диски, магнитооптические диски.

Дисководы — устройства чтения/записи информации на диски. Различают гибкие магнитные диски — дискеты и жесткие магнитные диски. Жесткие магнитные диски встроены в дисковод и в отличие от дискет являются несъемными.

Структура магнитного диска: одна или несколько сторон (магнитных поверхностей), разделенных на концентрические дорожки, каждая из которых, в свою очередь, поделена на сектора, состоящие из «клеточек» — байтов. Все секторы на одном диске имеют фиксированный размер. Вся работа по считыванию и записи данных на дисках производится только полными секторами. Полный объем памяти диска определяется формулой:

ОБЪЕМ = СТОРОНЫ*ДОРОЖКИ*СЕКТОРА*БАЙТЫ,

где СТОРОНЫ — количество сторон диска, ДОРОЖКИ — количество дорожек на стороне, СЕКТОРА — количество секторов на дорожке, БАЙТЫ — количество байт в секторе.

Информация на устройствах внешней памяти имеет файловую организацию. Файл — поименованная совокупность данных, хранящихся на внешнем носителе.

Файловая структура диска — это совокупность файлов на диске и взаимосвязей между ними.

Логический диск — это физический (реальный) диск или часть физического диска, которому присвоено собственное имя. Имена логических дисков задаются первыми буквами латинского алфавита с двоеточием: А:, В:, С: и т.д. Обычно с одним гибким магнитным диском связан один логический диск (А:, В), а жесткий диск делится на несколько логических (С:, D: и т.д.)

Каталог — это поименованная совокупность файлов и подкаталогов (т.е. вложенных каталогов). Каталог самого верхнего уровня иерархии называется корневым. Он не вложен ни в какие другие каталоги.

Путь к файлу — это последовательность, состоящая из имен каталогов (разделенных символом «\»), начиная от корневого и заканчивая тем, в котором непосредственно хранится файл.

Полное имя файла состоит из имени логического диска, пути к файлу и имени файла. В одном каталоге не может быть нескольких файлов и каталогов с одинаковыми именами. В разных каталогах это допустимо.

Дерево - графическое изображение иерархической файловой структуры диска.

Какое количество информации содержится, к примеру, в тексте романа "Война и мир", во фресках Рафаэля или в генетическом коде человека? Ответа на эти вопросы наука не дает и, по всей вероятности, даст не скоро. А возможно ли объективно измерить количество информации? Важнейшим результатом теории информации является следующий вывод: В определенных, весьма широких условиях можно пренебречь качественными особенностями информации, выразить ее количество числом, а также сравнить количество информации, содержащейся в различных группах данных.

В настоящее время получили распространение подходы к определению понятия

"количество информации", основанные на том, что информацию, содержащуюся в сообщении, можно нестрого трактовать в смысле ее новизны или, иначе, уменьшения неопределенности наших знаний об объекте. Эти подходы используют математические понятия вероятности и логарифма.

Подходы к определению количества информации. Формулы Хартли и

Шеннона.

Американский инженер Р. Хартли в 1928 г. процесс получения информации рассматривал как выбор одного сообщения из конечного наперед заданного множества из N равновероятных сообщений, а количество информации I, содержащееся в выбранном сообщении, определял как двоичный логарифм N.

Формула Хартли: I = log2N

Допустим, нужно угадать одно число из набора чисел от единицы до ста. По формуле

Допустим, нужно угадать одно число из набора чисел от единицы до ста. По формуле

Хартли можно вычислить, какое количество информации для этого требуется: I = log2100 > 6,644. Таким образом, сообщение о верно угаданном числе содержит количество информации, приблизительно равное 6,644 единицы информации.

Приведем другие примеры равновероятных сообщений:

1. при бросании монеты: "выпала решка", "выпал орел";

2. на странице книги: "количество букв четное", "количество букв нечетное".

Определим теперь, являются ли равновероятными сообщения "первой выйдет из

дверей здания женщина" и "первым выйдет из дверей здания мужчина". Однозначно ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, например, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины.

Для задач такого рода американский ученый Клод Шеннон предложил в 1948 г.

другую формулу определения количества информации, учитывающую возможную неодинаковую вероятность сообщений в

продолжение следует...

Часть 1 2: Физика информации, Философия информации, Закон сохранения информации, Информационное поле, Измерение и измеримость информации

Часть 2 - 2: Физика информации, Философия информации, Закон сохранения информации, Информационное

Часть 3 Возможные варианты разрешения - 2: Физика информации, Философия информации, Закон

Часть 4 Принцип взаимной информации - 2: Физика информации, Философия информации, Закон

Категория информации по отраслям знаний

В информатике

В общественных науках

В физиологии и медицине

В других областях

Выводы из данной статьи про физика информации указывают на необходимость использования современных методов для оптимизации любых систем. Надеюсь, что теперь ты понял что такое физика информации, философия информации, закон сохранения информации, информационное поле, измеримость информации и для чего все это нужно, а если не понял, или есть замечания, то не стесняйся, пиши или спрашивай в комментариях, с удовольствием отвечу. Для того чтобы глубже понять настоятельно рекомендую изучить всю информацию из категории Философия

Ответы на вопросы для самопроверки пишите в комментариях, мы проверим, или же задавайте свой вопрос по данной теме.

Комментарии

Оставить комментарий

Философия

Термины: Философия