Лекция

Привет, Вы узнаете о том , что такое качества в задачах классификации, Разберем основные их виды и особенности использования. Еще будет много подробных примеров и описаний. Для того чтобы лучше понимать что такое качества в задачах классификации, recision, recall, f-мера, roc-кривая , настоятельно рекомендую прочитать все из категории Вычислительный интеллект.

Оценка качества в задачах классификации — это процесс измерения эффективности модели машинного обучения в предсказании классов объектов. Существует несколько стандартных метрик, которые часто используются для оценки качества классификации:

Точность (Accuracy):

Точность (Precision):

Полнота (Recall или Sensitivity):

F1-мера (F1-Score):

ROC-AUC (Receiver Operating Characteristic - Area Under the Curve):

Матрица ошибок (Confusion Matrix):

Специфичность (Specificity):

Метрика Коэна (Cohen's Kappa):

Выбор метрик зависит от конкретной задачи и требований бизнеса. Важно учитывать контекст и веса ошибок в зависимости от целей классификации.

Здесь про TP, TN, FP, FN и понятия, через них выражающиеся, мы говорим в рамках одного класса бинарной классификации. То есть, в такой системе подразумевается, что реальное число объектов класса 0 (для бинарного случая 0/1) может выражаться как TP₀ + FN₀ = FP₁ + TN₁

Confusion matrix (матрица ошибок / несоответствий / потерь, CM)

— квадратная матрица размера k × k, где CMt,c — число объектов класса t , которые были квалифицированны как класс c , а k — число классов. Значения ячеек CM могут быть вычислены по формуле:  , где yi — реальный класс объекта, а yi^ — предсказанный.

, где yi — реальный класс объекта, а yi^ — предсказанный.

Для бинарного случая:

| Принадлежит классу (P) | Не принадлежит классу (N) | |

|---|---|---|

| Предсказана принадлежность классу | TP | FP |

| Предсказано отсутствие принадлежности к классу | FN | TN |

Для многоклассовой классификации матрица несоответствий строится по тому же принципу:

| Предсказанный класс | Класс 1 (C₁) | Класс 2 (C₂) | Класс 3 (C₃) |

|---|---|---|---|

| 1 (P₁) | T₁ | F₁₂ | F₁₃ |

| 2 (P₂) | F₂₁ | T₂ | F₂₃ |

| 3 (P₃) | F₃₁ | F₃₂ | T₃ |

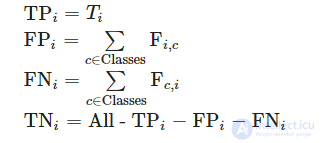

В этом случае TP, TN, FP и FN считаются относительно некоторого класса (i) следующим образом:

Acc=(TP + TN)/(TP + TN + FP + FN)

Recall=TP/(TP + FN)

Precision=TP/(TP + FP )

Specificity=TN /(FP + TN)

FPR=FP.(FP + TN)

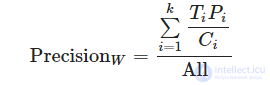

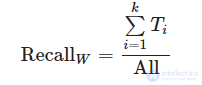

Ввиду того, что такие оценки никак не учитывают изначальное распределение классов в выборке (что может существенно влиять на полученное значение), также существуют взвешенные варианты этих оценок (в терминах многоклассовой классификации):

Примеры и картинки взяты из лекций курса «Введение в машинное обучение» К.В. Воронцова

Арифметическое среднее:

A=(1/2) *(precision + recall)

Таким образом, взятие среднего арифметического не является показательным.

Минимум:

M = min(precision, recall)

То есть, довольно неплохо отражает качество классификатора, не завышая его.

Но не отличает классификаторы с разными неминимальными показателями.

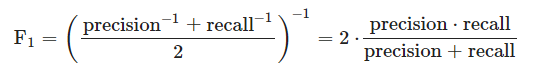

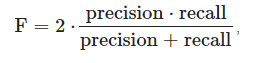

Гармоническое среднее, или f-мера :

Является наиболее точным усреднением, учитывает оба показателя.

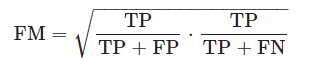

Геометрическое среднее, или Индекс Фоулкса–Мэллова (Fowlkes–Mallows index)

Менее строгая мера.

Для общей оценки качества классификатора часто используют F₁-меру. Оригинально она вычисляется для позитивного класса случая бинарной классификации, обобщается с помощью приниципа «один против всех» (описан подробнее ниже, для многоклассовой классификации). F₁-мера — среднее гармоническое между precision и recall:

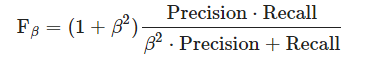

Среднее гармоническое взвешенное Fβ (F1-мера — частный случай Fβ-меры для β = 1). Fβ измеряет эффективность классификатора учитывая recall в β раз более важным чем precision:

F-мера для многоклассовой классификации. Три вида усреднения

Для вычисления F-меры (и других) метрик в рамках многоклассовой классификации используется подход «один против всех»: каждый класс ровно один раз становится «положительным», а остальные — отрицательным (пример вычисления изображен на матрице).

Таким образом, в зависимости от этапа вычисления, на котором производится усреднение, можно вычислить micro-average, macro-average и average F-меры (логика вычисления изображена на схеме справа). Микро- и макро-:

где для micro-average precision и recall вычислены из усредненных TP, FP, FN;

для macro-average precision и recall вычислены из усредненных precisioni, recalli;

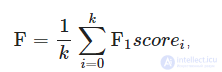

Усредненная:

где i — индекс класса, а k — число классов.

Для наглядной оценки качества алгоритма применяется ROC-кривая. Кривая строится на плоскости, определенной TPR (по оси ординат) и FPR (по оси абсцисс).

Для построении графика используется мягкая классификация: вместо того, чтобы четко отнести объект к классу, классификатор возвращает вероятности принадлежности объекта к различным классам. Эта уверенность сравнивается с порогом (какой уверенности «достаточно», чтобы отнести объект к положительному классу). В зависимости от значения этого порога меняются значения TPR и FPR.

Алгоритм построения кривой:

Таким образом: число точек не превосходит число объектов идеальному алгоритму соответствует ROC-кривая, проходящая через точку (0;1)(0;1) худшему алгоритму (например, монетке) соответствует прямая TPR = FPR.

Для численной оценки алгоритма по ROC-кривой используется значение площади под ней (AUC, area under curve). Идеальный алгоритм имеет AUC, равный 1, худший — 0,5.

С другой стороны, для построения ROC-кривой не обязательно пересчитывать TPR и FPR.

Существует альтернативный алгоритм построения ROC-кривой.

Корректность алгоритма обосновывается тем, что с изменением предсказания для одного объекта в зависимости от его класса меняется либо TPR, либо FPR (значение второго параметра остается прежним). Ниже описана другая логика, подводящая к алгоритму выше.

Напомним, что мы работаем с мягкой классификацией.

Рассмотрим примеры (графики accuracy, цветом указан реальный класс объекта: красный — положительный, синий — отрицательный). Отсортируем наши объекты по возрастанию уверенности классификатора в принадлежности объекта к положительному классу. Допустим, что объекты находятся на равном (единичном) расстоянии друг от друга.

Начнем перебирать «границу раздела»: если граница в нуле — мы решаем относить все объекты к положительному классу, тогда accuracy = 1/2. Последовательно сдвигаем границу по единичке вправо:

Таким образом, на графиках слева, видно, что:

Заметим, что, повернув график на 45 градусов, мы получим ROC-кривые для соответствующих классификаторов (графикам accuracy слева соответствуют ROC-кривые справа). Так объясняется альтернативный алгоритм построения ROC-кривой.

Обоснование: Чувствительность к соотношению классов.

Рассмотрим задачу выделения математических статей из множества научных статей. Допустим, что всего имеется 1.000.100 статей, из которых лишь 100 относятся к математике. Если нам удастся построить алгоритм a(x)�(�), идеально решающий задачу, то его TPR будет равен единице, а FPR — нулю. Рассмотрим теперь «плохой» алгоритм, дающий положительный ответ на 95 математических и 50.000 нематематических статьях. Такой алгоритм совершенно бесполезен, но при этом имеет TPR = 0.95 и FPR = 0.05, что крайне близко к показателям идеального алгоритма. Таким образом, если положительный класс существенно меньше по размеру, то AUC-ROC может давать неадекватную оценку качества работы алгоритма, поскольку измеряет долю неверно принятых объектов относительно общего числа отрицательных. Так, алгоритм b(x) помещающий 100 релевантных документов на позиции с 50.001-й по 50.101-ю, будет иметь AUC-ROC 0.95.

Precison-recall (PR) кривая.

Избавиться от указанной проблемы с несбалансированными классами можно, перейдя от ROC-кривой к PR-кривой. Она определяется аналогично ROC-кривой, только по осям откладываются не FPR и TPR, а полнота (по оси абсцисс) и точность (по оси ординат). Критерием качества семейства алгоритмов выступает площадь под PR-кривой (англ. Area Under the Curve — AUC-PR)

Исследование, описанное в статье про качества в задачах классификации, подчеркивает ее значимость в современном мире. Надеюсь, что теперь ты понял что такое качества в задачах классификации, recision, recall, f-мера, roc-кривая и для чего все это нужно, а если не понял, или есть замечания, то не стесняйся, пиши или спрашивай в комментариях, с удовольствием отвечу. Для того чтобы глубже понять настоятельно рекомендую изучить всю информацию из категории Вычислительный интеллект

Комментарии

Оставить комментарий

Вычислительный интеллект

Термины: Вычислительный интеллект