Лекция

Сразу хочу сказать, что здесь никакой воды про многозадачное обучение, и только нужная информация. Для того чтобы лучше понимать что такое многозадачное обучение, multi task learning , настоятельно рекомендую прочитать все из категории Машинное обучение.

одновременное обучение группе взаимосвязанных задач, для каждой из которых задаются свои пары «ситуация, требуемое решение»

многозадачное обучение (Multi-Task Learning) - это метод машинного обучения, противоположный однозадачному обучению. В области машинного обучения стандартная теория алгоритмов заключается в изучении одной задачи за раз, то есть в случае, когда выходными данными системы является действительное число. Сложная проблема обучения сначала разлагается на теоретически независимые подзадачи, затем каждая подзадача изучается отдельно, и, наконец, математическая модель сложной задачи устанавливается посредством комбинации результатов обучения подзадач. Многозадачное обучение - это вид совместного обучения, при котором несколько задач изучаются параллельно, а результаты влияют друг на друга.

Проведите простое сравнение со школьными данными, которые все часто используют. Школьные данные - это набор данных, используемый для прогнозирования проблемы регрессии успеваемости учащихся. Всего в 139 средних школах учатся 15 362 ученика, и каждую среднюю школу можно рассматривать как задача прогнозирования. Однозадачное обучение заключается в игнорировании возможных взаимосвязей между задачами и изучении 139 функций регрессии для прогнозирования оценок или непосредственном объединении всех данных 139 школ, чтобы изучить функцию регрессии для прогнозирования. Многозадачное обучение подчеркивает связь между задачами. Благодаря совместному обучению различные функции регрессии изучаются одновременно для 139 задач, что учитывает различия между задачами и связь между задачами. Это также многозадачное обучение. Одно из самых важных мыслей.

В машинном обучении мы обычно заботимся об оптимизации конкретного индикатора, независимо от того, является ли индикатор стандартным значением или корпоративным KPI. Для достижения этой цели мы обучаем одну модель или набор из нескольких моделей для выполнения указанных задач. Затем мы улучшили модель, настроив параметры до тех пор, пока производительность не перестанет улучшаться. Хотя это может обеспечить приемлемую производительность для задачи, мы могли упустить некоторую информацию, которая помогает улучшить показатели, которые нам важны. В частности, эта информация представляет собой данные наблюдения за соответствующими задачами. Распространяя информацию о представлении среди связанных задач, наша модель имеет лучшую производительность обобщения для исходной задачи. Этот метод называется многозадачным обучением, и он является основной темой этого сообщения в блоге.

Существует множество форм многозадачного обучения, таких как совместное обучение, обучение для обучения, обучение с помощью вспомогательных задач и т. Д. Это лишь некоторые из псевдонимов. Таким образом, как только вы обнаружите, что оптимизируете более одной целевой функции, вы можете эффективно решить ее с помощью многозадачного обучения (как правило, как только вы обнаружите, что оптимизируете более одной функции потерь, вы эффективно выполняете многозадачное обучение. (в отличие от однозадачного обучения)). В таком сценарии это помогает понять, что мы на самом деле собираемся делать, и черпать из этого вдохновение.

Даже если ваша цель оптимизации - только одна в самой особой ситуации, вспомогательная задача может помочь вам улучшить эффективность обучения основной задаче. Рич Каруана заключил в : «Многозадачное обучение улучшает производительность обобщения за счет использования знаний предметной области, содержащихся в контрольных сигналах связанных задач». Изучая это сообщение в блоге, мы постараемся сделать краткий обзор недавнего состояния исследований многозадачного обучения, особенно многозадачного обучения для глубоких нейронных сетей. Во-первых, мы изучили источники вдохновения для многозадачного обучения. Затем представьте два наиболее распространенных метода многозадачного обучения. Затем описывается механизм, который делает многозадачное обучение эффективным на практике. Прежде чем обобщать более продвинутые методы многозадачного обучения на основе нейронных сетей, мы рассмотрели некоторые базовые знания из предыдущей литературы по многозадачному обучению. Затем в этой статье представлены некоторые мощные многозадачные методы обучения, основанные на глубоких нейронных сетях, которые были предложены в последние годы. Наконец, мы обсудили типы часто используемых вспомогательных задач и характеристики вспомогательных задач, которые подходят для многозадачного обучения.

Ранние исследования многозадачного обучения возникли в результате изучения важной проблемы машинного обучения, а именно проблемы «индуктивного смещения». Процесс машинного обучения можно рассматривать как процесс анализа эмпирических данных, относящихся к проблеме, и обобщения модели, отражающей характер проблемы из нее. Функция индуктивного смещения состоит в том, чтобы направлять алгоритм обучения тому, как искать в пространстве модели. Индуктивное смещение напрямую влияет на производительность модели, в которой проводится поиск, и любая обучающая система, в которой отсутствует индуктивное смещение, не может быть эффективной. Обучение. Различные алгоритмы обучения (например, деревья решений, нейронные сети, машины опорных векторов и т. Д.) Имеют разные индуктивные смещения. Людям необходимо вручную определять, какой алгоритм обучения использовать при решении практических задач. На самом деле они выбирают разные алгоритмы субъективно. Индуктивное смещение стратегия. Очень интуитивно понятно, может ли процесс определения индуктивного смещения также быть автоматически завершен в процессе обучения, то есть принята идея «научиться учиться». Многозадачное обучение обеспечивает реальный способ реализации вышеупомянутых идей, то есть использовать полезную информацию, содержащуюся в связанных задачах, чтобы обеспечить более сильную индуктивную предвзятость для изучения соответствующей задачи.

Текущие методы многозадачного обучения можно грубо разделить на две категории: одна использует одни и те же общие параметры для разных задач , а другая - поиск скрытых функций, скрытых между разными задачами .

Мы предлагаем разнообразить отправные точки многозадачного обучения:

(1) С точки зрения биологии, мы рассматриваем многозадачное обучение как симуляцию обучения человека. Чтобы изучить новую задачу, мы обычно используем знания, полученные в задачах, связанных с обучением. Например, младенцы сначала учатся распознавать лица, а затем используют эти знания для распознавания других объектов.

(2) С точки зрения педагогики, первая задача, которую мы изучаем, - это те навыки, которые могут помочь нам овладеть более сложными технологиями. Это очень правильный метод обучения боевым искусствам и программированию. В качестве примера, который не воспринимается общественностью, в фильме «Каратэ-пацан» г-н Мияги учит детей-карате полировать пол и воском машину, что указывает на то, что это не имеет значения. Однако оказалось, что именно эти тривиальные задания дали ему необходимые навыки для изучения карате.

(3) С точки зрения машинного обучения мы рассматриваем многозадачное обучение как индуктивный перенос. Индуктивный перенос улучшает модель, вводя индуктивное смещение, делая модель более склонной к определенным предположениям. Например, обычным индуктивным смещением является регуляризация L1, что делает модель более склонной к разреженным решениям. В сценариях многозадачного обучения индуктивное смещение обеспечивается вспомогательными задачами, что заставляет модель быть более склонной к решениям, которые могут объяснить несколько задач одновременно. Далее мы увидим, что это улучшит характеристики обобщения модели.

Ранее мы обсуждали теоретический источник многозадачного обучения. Чтобы сделать идею многозадачного обучения более конкретной, мы покажем два метода, обычно используемых в многозадачном обучении на основе глубоких нейронных сетей: жесткое совместное использование и мягкое совместное использование параметров скрытого слоя.

(1) Механизм жесткого разделения параметров: Механизм жесткого разделения параметров является наиболее распространенным методом многозадачного обучения нейронных сетей, который можно найти в литературе . Об этом говорит сайт https://intellect.icu . Вообще говоря, его можно применить ко всем скрытым слоям всех задач, сохранив выходной слой, связанный с задачей. Механизм жесткого разделения снижает риск переобучения. Фактически, литература доказывает, что порядок риска переобучения этих общих параметров равен N, где N - количество задач, которое меньше, чем риск переобучения параметров, связанных с задачей. Интуитивно это очень важно. Чем больше задач мы изучаем одновременно, тем больше задач наша модель может охватить одно и то же представление, что снижает риск переобучения наших исходных задач.

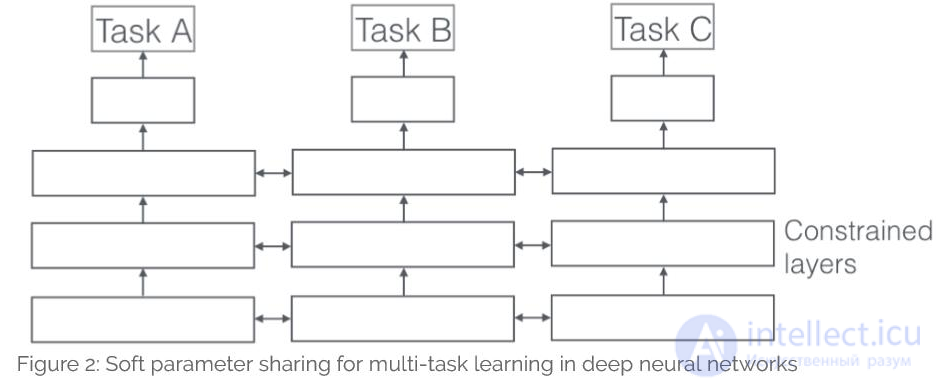

(2) Механизм мягкого разделения параметров: каждая задача имеет свою модель и свои параметры. Мы упорядочиваем расстояние между параметрами модели, чтобы обеспечить схожесть параметров. В литературе используется регуляризация расстояния L2, а в литературе используется норма следа. На ограничения механизма мягкого разделения, используемого в глубоких нейронных сетях, в значительной степени влияют методы регуляризации в традиционном многозадачном обучении. Обсудим это дальше.

Несмотря на то, что объяснение предвзятости сокращения из-за многозадачного обучения очень популярно, чтобы лучше понять многозадачное обучение, мы должны изучить его основной механизм. Большинство механизмов было предложено Каруаной еще в 1998 году. Чтобы упростить описание расстояния, мы предполагаем, что есть две связанные задачи A и B, которые разделяют представление скрытого слоя F.

(1) Механизм увеличения скрытых мировых данных. Многозадачное обучение эффективно увеличивает количество обучающих примеров. Поскольку все задачи имеют более или менее шум, например, когда мы обучаем модель задаче A, наша цель - получить хорошее представление задачи A, игнорируя при этом шум, связанный с данными, и производительность обобщения. Поскольку разные задачи имеют разные шаблоны шума, модель, которая изучает две задачи одновременно, может изучить более общие представления.). Если только задача обучения A несет риск переобучения задаче A, в то время как задача обучения A и задача B одновременно усредняют картину шума, модель может получить лучшее представление F.

(2) Механизм внимания. Если задача является зашумленной, объем данных невелик, а размерность данных высока, модели становится трудно различать релевантные и нерелевантные функции. Многозадачность помогает сосредоточить внимание модели на тех функциях, которые действительно имеют большое значение, поскольку другие задачи могут предоставить дополнительные доказательства корреляции и некорреляции функций.

(3) Механизм подслушивания. Некоторые функции G легко изучить для задачи B, но эти функции сложно изучить для задачи A. Это может быть связано с тем, что взаимодействие между задачей A и функцией G является более сложным, или потому, что другие функции препятствуют изучению функции G. Благодаря многозадачному обучению мы можем позволить модели подслушивать (подслушивать), то есть использовать задачу B для изучения функции G. Самый простой способ добиться этого - использовать подсказки , то есть обучить модель напрямую предсказывать, какие особенности являются наиболее важными.

(4) Представляет механизм смещения. Многозадачное обучение более склонно к изучению типа модели, которая подчеркивает ту часть представления, которая также подчеркивается другими задачами. Поскольку пространство гипотез, которое хорошо работает для достаточного количества обучающих задач, также будет хорошо работать для новых задач из той же среды, это поможет модели продемонстрировать свою способность к обобщению для новых задач

(5) Механизм регуляризации. Многозадачное обучение играет ту же роль, что и регуляризация, вводя индуктивное смещение. Таким образом, он снижает риск переобучения модели и в то же время снижает ее сложность по Радемахеру, то есть способность подгонять случайный шум.

Хотя многие недавние работы по глубокому обучению явно или неявно используют многозадачное обучение как часть своей модели, метод использования по-прежнему не превышает двух методов, которые мы упоминали ранее: жесткое совместное использование и мягкое совместное использование параметров. Напротив, лишь небольшая часть работы посвящена предложению хороших механизмов многозадачного обучения в глубоких нейронных сетях.

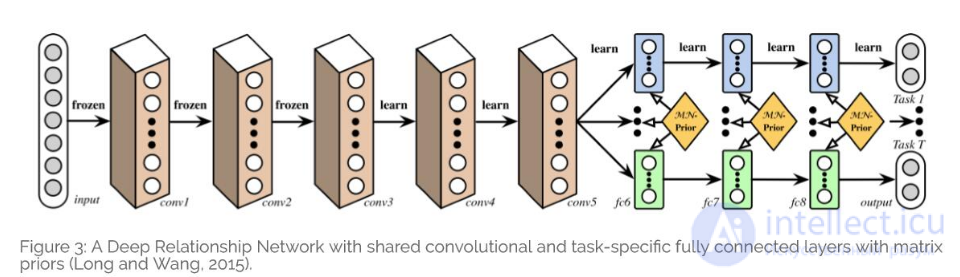

В многозадачных сценариях для машинного зрения эти существующие методы обычно используют общие сверточные слои и рассматривают полностью связанный слой как связанный с задачей. Литература [34] предлагает глубокую сеть взаимоотношений. В дополнение к структуре общего уровня и уровня, связанного с задачами, они добавляют матрицу перед полностью подключенным уровнем. Это позволит модели узнать отношения между задачами. Это похоже на байесовский метод, который мы видели ранее. Однако проблема в том, что этот метод по-прежнему полагается на заранее заданную общую структуру. Этого достаточно для проблем с машинным зрением, но для новых задач он может оказаться неправильным.

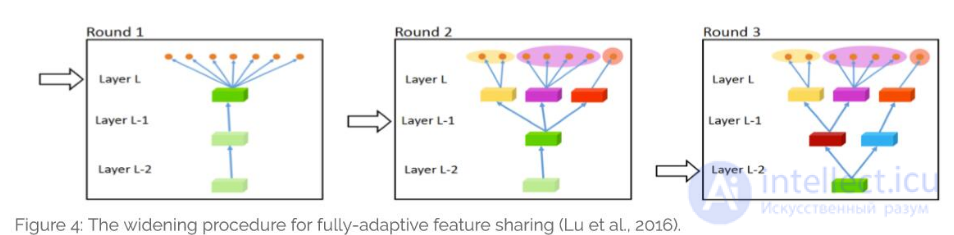

С другой стороны, литература [35] предлагает восходящий подход. Начиная с тонкой сети, используя индикаторы, которые автоматически группируют похожие задачи, жадно и динамически расширяют сеть. Этот процесс расширения динамически создает ветви, как показано на рисунке 4. Однако этот жадный подход не дает в целом наилучшего. Назначение конкретной задачи каждой ветви не позволяет модели изучать более сложные взаимодействия между задачами.

Литература [36] связывает две независимые сети с мягким разделением параметров. Затем они описали, как использовать так называемый модуль вышивки крестиком, чтобы определить, как использовать знания, полученные из других задач в сети, связанных с этими задачами, и линейно комбинировать выходные данные предыдущего слоя. Эта структура показана на рисунке 5, и модуль вышивки крестом добавляется только после объединяющего слоя и полностью связанного слоя.

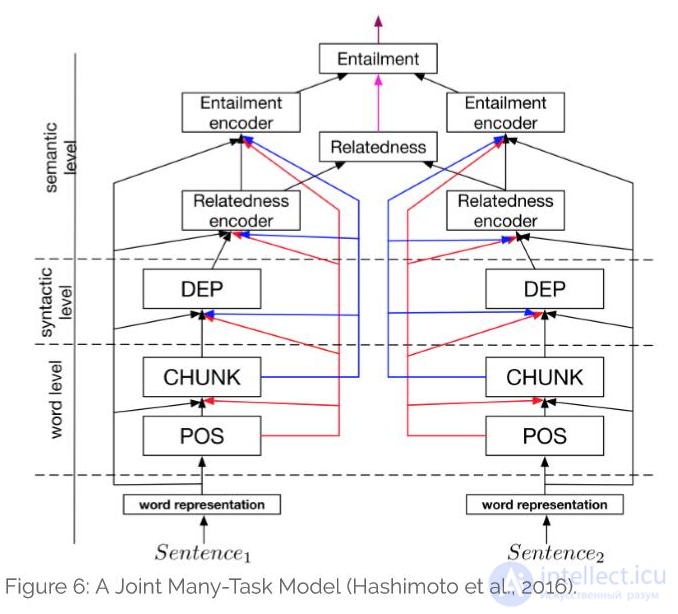

Напротив, в последние годы в центре внимания многозадачного обучения в области обработки естественного языка находится поиск хорошей иерархической структуры: в литературе [37] показано, что некоторые основные задачи в НЛП, такие как тегирование части речи, называются распознавание сущностей и т. д. должно быть В качестве вспомогательной задачи контролируемое обучение выполняется на более низком уровне.

Основываясь на этом открытии, в литературе [38] заранее определена иерархическая структура, содержащая несколько задач НЛП, как показано на рисунке 6, и использована ее в качестве совместной модели для многозадачного обучения.

В дополнение к разделению структуры обучения в литературе [39] используется ортогональный метод для рассмотрения неопределенности каждой задачи. Они регулируют относительный вес каждой задачи в функции стоимости и достигают цели многозадачного обучения на основе принципа максимизации функции вероятности неопределенности, связанной с задачей. На рисунке 7 показана структура трех задач: глубинной регрессии, семантической сегментации и сегментации экземпляров для каждого пикселя u.

5.7 Тензорная декомпозиция в многозадачном обучении

Во многих недавних работах предпринимались попытки расширить существующую модель многозадачного обучения до глубокого обучения: в литературе [40] некоторые из существующих методов разложения тензора были расширены до разделения параметров модели для разложения коэффициентов корреляции между общими параметрами каждого уровня и задачи. .

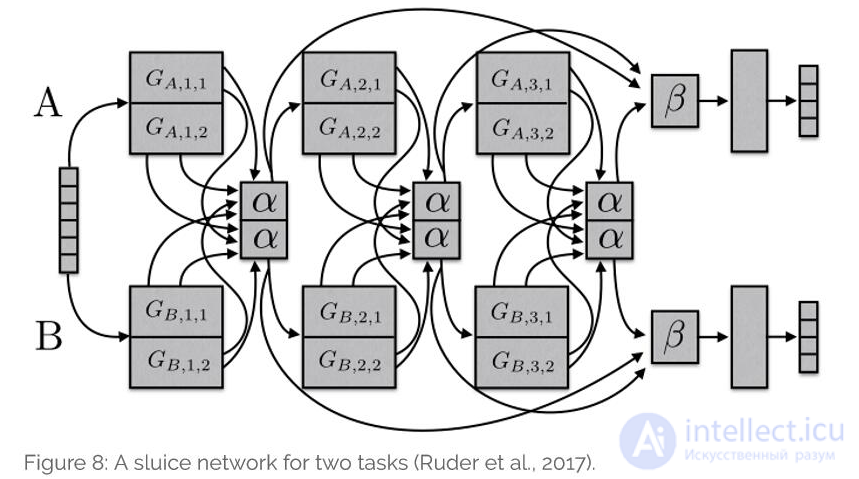

Наконец, давайте поговорим о сети шлюзов, упомянутой в [41], которая является обобщением множества методов многозадачного обучения, основанных на глубоких нейронных сетях. Как показано на рисунке 8, эта модель может узнать, какие подпространства в каждом слое должны быть общими, а какие используются для изучения хорошего представления входной последовательности.

Рассмотрев эти связанные работы, давайте подытожим, какой информацией следует делиться в модели глубокого многозадачного обучения. В большинстве случаев многозадачного обучения задачи поступают из одного и того же распределения. Хотя этот сценарий выгоден для совместного использования, он не всегда верен. Чтобы разработать более надежную многозадачную модель, мы должны иметь дело с несвязанными задачами.

Ранние многозадачные модели, используемые для глубокого обучения, требовали предопределенной общей структуры между задачами. Эта стратегия не подходит для расширения и сильно зависит от структуры многозадачности. Технология жесткого разделения параметров, которая была предложена еще в 1997 году, все еще остается мейнстримом сегодня, 20 лет спустя. Хотя механизм жесткого разделения параметров полезен во многих сценариях, если связь между задачами не так тесна или требуется многоуровневое рассуждение, технология жесткого обмена скоро выйдет из строя. Недавно были также проведены некоторые исследования работы, чтобы узнать, чем можно делиться , и производительность этих работ будет лучше, чем механизм жесткого разделения в общем смысле. Кроме того, если модель известна, также полезно узнать емкость иерархии задач, особенно в сценариях с множественной степенью детализации.

Как упоминалось в начале, как только нам нужно решить многоцелевую задачу оптимизации, мы приступаем к многозадачному обучению. Многозадачность должна быть не только ограничена выражением знаний обо всех задачах в виде одного и того же пространства параметров, но и уделять больше внимания тому, как заставить нашу модель изучать интерактивный режим между задачами (таким образом, полезно использовать достижения в MTL. что мы обсудили и позволили нашей модели узнать, как задачи должны взаимодействовать друг с другом).

Для сценариев, в которых результаты прогнозирования нескольких задач получаются одновременно, многозадачное обучение, естественно, подходит. Этот сценарий распространен в финансовых или экономических прогнозах. Например, нам может потребоваться знать как соответствующие факторы воздействия, так и результаты прогнозов. В биоинформатике мы можем захотеть узнать симптомы нескольких заболеваний одновременно. Но в большинстве случаев мы сосредотачиваемся только на одной задаче. В этом разделе мы обсудим, как найти вспомогательную задачу, которая принесет пользу многозадачному обучению.

Использование связанных задач в качестве вспомогательных - типичный выбор для многозадачного обучения. Хотите узнать, что такое «актуальная задача», здесь мы показываем несколько интуитивно понятных примеров. Каруана использовал прогнозирование характеристик различных дорог в 1997 году, чтобы научиться управлять автономным вождением. В литературе [42] используется оценка позы головы и вывод атрибутов черт лица, чтобы облегчить задачу обнаружения контуров лица. В литературе [43] изучаются как классификация запросов, так и поиск в Интернете. Литература [44] одновременно предсказывает категорию и расположение объектов на изображении. Литература [45] также предсказывает продолжительность и частоту фонем в процессе преобразования текста в язык.

Обычно аннотационные данные для связанной задачи отсутствуют. Однако в некоторых случаях задачи, которые мы можем использовать, противоположны тем, которых мы хотим достичь . Такие данные можно использовать для борьбы с потерями. Эти потери используются не для минимизации, а для использования слоя обратного градиента, чтобы максимизировать ошибку обучения . Литература [46] показывает успешный пример этого сценария в адаптации предметной области. Состязательная задача в этом сценарии используется для прогнозирования поля ввода. Изменяя градиент задачи конфронтации, потеря задачи конфронтации увеличивается до максимума. Это полезно для основной задачи и может побудить модель изучить представление двух доменов, не различая его.

Как упоминалось ранее, при многозадачном обучении можно изучить функции, которые невозможно изучить при выполнении одной задачи. Использование подсказок - такой эффективный механизм: прогнозирование функций во вспомогательных задачах. Недавний пример - обработка естественного языка. В литературе [47] вопрос о том, содержит ли входное предложение слова с положительными и отрицательными эмоциями, используется в качестве вспомогательной задачи при анализе настроений. Литература [48] будет судить, содержит ли предложение имя в качестве вспомогательной задачи при распознавании неправильного имени.

Вспомогательные задачи могут использоваться для сосредоточения внимания на определенных частях изображения, которые сеть может игнорировать. Например, для задач, контролируемых направлением обучения, модель отдельной задачи обычно игнорирует тонкости этих изображений, таких как дорожные знаки. Тогда прогнозирование дорожных знаков можно использовать как вспомогательную задачу. Заставив модель научиться их изображать, такие знания можно использовать для основной задачи. Точно так же для распознавания лиц, поскольку эти лица разные, мы можем использовать прогнозирование положения черт лица в качестве вспомогательной задачи.

Для многозадачности цель оптимизации количественно определена. Обычно популярен непрерывный тип, а доступные этикетки представляют собой дискретные наборы. В большинстве случаев ручная оценка требуется для сбора данных, например, для прогнозирования риска заболевания или анализа настроений (положительный, отрицательный, нейтральный). Поскольку целевая функция является гладкой, использование меньшего количества количественных вспомогательных задач упростит изменение обучения .

В некоторых случаях использование определенных функций в качестве входных данных не способствует прогнозированию целевых выходных данных. Однако они могут управлять процессом обучения с учителем. В этих ситуациях функция является частью вывода, а не ввода. В литературе [49] показаны сценарии решения этих проблем в практических приложениях.

Некоторые функции во многих сценариях доступны только после прогнозирования. Например, при автономном вождении, когда автомобиль проезжает препятствия или дорожные знаки, их можно точно измерить. Каруана привел пример пневмонии в 1997 году. Только после инцидента могут быть доступны дополнительные диагностические случаи. Для этих примеров эти дополнительные данные недоступны в момент ввода, поэтому их нельзя использовать в качестве функций. Однако его можно использовать как вспомогательную задачу, чтобы передать модели дополнительные знания для помощи в обучении.

Цель вспомогательных задач в многозадачном обучении - заставить модель изучить общее представление, чтобы помочь в изучении основной задачи. Вспомогательные задачи, которые мы сейчас обсуждаем, делают это неявно. Поскольку они тесно связаны с основной задачей, они могут позволить этим моделям изучать представления, которые способствуют выполнению основной задачи во время обучения. Более явный подход - использовать вспомогательную задачу специально для изучения переносимого представления. Такую роль сыграли работа Ченг и др. 2015 г. и цель языковой модели, используемая в литературе [50]. Точно так же автоэнкодер можно использовать и для вспомогательных задач.

Хотя на практике нас может интересовать только одна вспомогательная задача, мы обсудили различные вспомогательные задачи, которые можно использовать в многозадачном обучении. Хотя мы не знаем, что сработает на практике. Основное предположение для поиска вспомогательных задач: вспомогательные задачи должны быть тесно связаны с основной задачей или быть полезными для процесса обучения основной задаче.

Однако мы не знаем, какие две задачи связаны или похожи. В 1997 году Каруана дал следующее определение: если две задачи используют одни и те же характеристики для принятия решений, то эти две задачи похожи. В 2000 году Баксер добавил: Теоретически связанные задачи имеют один и тот же оптимальный класс гипотез, то есть одно и то же индуктивное смещение. В литературе [50] предлагается, что если данные в двух задачах генерируются одним и тем же типом преобразования F для получения фиксированного распределения вероятностей, то эти две задачи связаны F. Хотя его можно использовать для одной и той же задачи классификации, его нельзя использовать для задач, связанных с разными проблемами. Сюэ и др. Предложили в 2007 году, что если граница классификации (вектор параметров) двух задач закрыта, то эти две задачи похожи.

Хотя на начальном этапе был достигнут некоторый прогресс в понимании теоретического определения релевантности задачи, недавние результаты - нет. Сходство задач не бинарное, а диапазонное. Две более похожие задачи получают больше преимуществ от многозадачного обучения, и наоборот. Это позволяет нашей модели узнать, какие параметры использовать, что может только временно преодолеть теоретические недостатки и лучше использовать задачи, которые не связаны между собой . Однако нам также необходимо теоретическое понимание подобия задач, которое поможет нам понять, как выбирать вспомогательные задачи.

В литературе [52] было обнаружено, что вспомогательные задачи с полным и равномерным распределением меток должны быть более полезными для основной задачи маркировки последовательностей , что было проверено экспериментально. Кроме того, в литературе [53] было обнаружено, что вспомогательные задачи отсутствия плато также улучшают основные задачи выхода на плато.

Однако масштабы этих экспериментов ограничены. Эти недавние результаты исследований дают лишь некоторые подсказки для нашего дальнейшего понимания многозадачного обучения в нейронных сетях.

Эта статья посвящена истории многозадачного обучения и последним разработкам в области многозадачного обучения в глубоких нейронных сетях. Хотя многозадачное обучение часто используется, жесткий механизм разделения параметров последних 20 лет по-прежнему остается основной парадигмой многозадачного обучения в нейронных сетях. Работа по изучению того, какой информацией поделиться, выглядит более многообещающей. В то же время наше понимание схожести задач, взаимосвязи между задачами, уровня задач и преимуществ многозадачного обучения по-прежнему ограничено. Нам нужно узнать больше, чтобы понять возможности обобщения многозадачного обучения в глубоком нейронные сети.

А как ты думаешь, при улучшении многозадачное обучение, будет лучше нам? Надеюсь, что теперь ты понял что такое многозадачное обучение, multi task learning и для чего все это нужно, а если не понял, или есть замечания, то не стесняйся, пиши или спрашивай в комментариях, с удовольствием отвечу. Для того чтобы глубже понять настоятельно рекомендую изучить всю информацию из категории Машинное обучение

Комментарии

Оставить комментарий

Машинное обучение

Термины: Машинное обучение