Лекция

Привет, мой друг, тебе интересно узнать все про китайская комната, тогда с вдохновением прочти до конца. Для того чтобы лучше понимать что такое китайская комната, бумажная машина тьюринга , китайская нация, chinese room, мысленный эксперимент , настоятельно рекомендую прочитать все из категории Подходы и направления создания Искусственного интеллекта.

Понятие « мысленный эксперимент » ввел австрийский физик, механик и философ – Эрнест Мах.

Мысленный эксперимент — вид познавательной деятельности, в которой ключевая для той или иной научной теории ситуация разыгрывается не в реальном эксперименте, а в воображении.

китайская комната (англ. Chinese room) — мысленный эксперимент в области философии сознания и философии искусственного интеллекта, впервые опубликованный Джоном Серлом в 1980 году. Цель эксперимента состоит в опровержении утверждения о том, что цифровая машина, наделенная «искусственным интеллектом» путем ее программирования определенным образом, способна обладать сознанием в том же смысле, в котором им обладает человек. Иными словами, целью является опровержение гипотезы так называемого «сильного» искусственного интеллекта и критика теста Тьюринга.

Этот философский аргумент до сих пор является одним из самых обсуждаемых в области когнитивистики. Некоторые исследователи даже определяют когнитивистику как «исследовательский проект по опровержению аргумента Серла». Только с 2010 по 2014 год было выпущено более 750 статей в научных журналах, где обсуждается мысленный эксперимент Серла.

Последний мысленный эксперимент, который будет описан, по-видимому, является самым известным из всех. Идея этого эксперимента принадлежит Джону Сирлу, описавшему гипотетическую систему, в отношении которой любому наблюдателю ясно, что она работает под управлением какой-то программы и успешно проходит тест Тьюринга, но также ясно (согласно Сирлу), что эта система не понимает смысла каких-либо из ее входных или выходных данных. На основании этого Сирл делает вывод, что работа системы под управлением приемлемой программы (т.е. программы, вырабатывающей правильные выходные данные) не является достаточным условием для обладания разумом.

Система состоит из человека, который понимает только английский язык, снабжен книгой с правилами, написанной на английском языке, а в его распоряжении находятся разные стопки бумаг, причем некоторые из них пусты, а другие заполнены описаниями, не поддающимися расшифровке. (Таким образом, человек играет роль процессора компьютера, книга правил представляет собой программу, а стопки бумаг соответствуют запоминающему устройству.) Система находится в комнате с небольшим отверстием, выходящим наружу.

Через отверстие появляются полоски бумаги с символами, не поддающимися расшифровке. Человек находит совпадающие с ними символы в книге правил и следует обнаруженным в ней инструкциям. Инструкции могут предусматривать задания по написанию символов на новых полосках бумаги, поиску символов в стопках, переупорядочению стопок и т.д. В конечном итоге инструкции диктуют необходимость написания одного или нескольких символов на листе бумаги, который снова передается во внешний мир.

До сих пор все шло нормально. Но из внешнего мира мы видим систему, которая принимает входные данные в форме предложений на китайском языке и формирует ответы на китайском, которые внешне кажутся "интеллектуальными", как и беседа, мысленно представленная Тьюрингом. После этого Сирл проводит следующие рассуждения: человек, сидящий в комнате, не понимает китайского (это дано). Книга правил и стопки бумаги, будучи просто листами бумаги, не понимают китайского. Поэтому речь не может идти о каком-либо понимании китайского языка, Поэтому, согласно Сирлу, эксплуатация даже подходящей программы не обязательно приводит к развитию понимания.

Как и Тьюринг, Сирл рассмотрел и попытался опровергнуть целый ряд ответов на его доводы. Некоторые комментаторы, включая Джона Маккарти и Роберта Виленского, выдвинули предложения, которые Сирл назвал системными ответами. Их возражение состоит в том, что человека, сидящего в комнате, безусловно, можно спросить, понимает ли он китайский язык, но это аналогично тому, как если бы процессор компьютера спросили, может ли он извлекать кубические корни. В обоих случаях ответ является отрицательным и в обоих случаях, согласно системному ответу, вся система обладает способностью, которая была предметом вопроса.

Безусловно, если задать системе с китайской комнатой вопрос на китайском языке, знает ли она китайский, ответ будет утвердительным (и сформулированным на живом китайском языке). Согласно корректному соглашению Тьюринга, этого должно быть достаточно. Ответ Сирла — это возврат к той идее, что понимание не заключено в мозгу человека, сидящего в китайской комнате, и не может быть заключено в стопках бумаги, поэтому не может быть никакого понимания. Далее Сирл указывает, что можно представить себе ситуацию, когда человек запоминает книгу правил и содержимое всех стопок бумаги, поэтому больше нет ни одного объекта, которому можно было бы приписать понимание, кроме самого человека; но и после этого, если ему будет задан вопрос (на английском языке), понимает ли он китайский, ответ будет отрицательным.

Теперь перейдем к реальному анализу этой проблемы. Переход от эксперимента с использованием стопок бумаги к эксперименту с запоминанием — это просто попытка сбить читателя с толку, поскольку обе формы представляют собой варианты физического воплощения работающей программы. Фактические утверждения, выдвинутые Сирлом, опираются на четыре приведенных ниже аксиомы.

На основании первых трех аксиом Сирл делает вывод, что программы не могут служить достаточным условием для появления разума. Иными словами, агент, в котором функционирует какая-то программа, может оказаться разумным, но он не обязательно становится разумным лишь в силу того, что в нем работает программа.

На основании четвертой аксиомы Сирл делает вывод: "Любая другая система, способная порождать разум, должна обладать причинной мощью (по меньшей мере), эквивалентной той, какой обладает мозг". На основании этого он делает вывод, что любой искусственный мозг должен воплощать в себе такую же причинную мощь, как и мозг, а не только работать под управлением конкретной программы, и что мозг человека не вырабатывает мыслительные феномены исключительно благодаря тому, что в нем функционирует какая-то программа.

Вывод о том, что применения программ недостаточно для создания разума, действительно следует из этих аксиом, если допускается их вольная интерпретация. Но само обоснование вывода проведено неудовлетворительно — все, что смог доказать Сирл, состоит в том, что если явно отвергнуты принципы функционализма (как было сделано в его третьей аксиоме), то заключение, согласно которому объекты, отличные от мозга, порождают разум, становится необязательным. Это предположение вполне обосновано, поэтому вся дискуссия сводится к тому, может ли быть принята третья аксиома. Согласно Сирлу, весь смысл эксперимента с китайской комнатой состоит в предоставлении интуитивного обоснования для третьей аксиомы. Но реакция других исследователей показывает, что такие интуитивные представления близки по духу только тем, кто уже был склонен соглашаться с идеей, что программы, взятые в чистом виде, не способны вырабатывать истинное понимание.

Еще раз отметим, что цель эксперимента с китайской комнатой состоит в опровержении понятия сильного искусственного интеллекта— утверждения, что эксплуатация программы подходящего типа обязательно приводит к появлению разума. Этот мысленный эксперимент проводится путем демонстрации внешне интеллектуальной системы, в которой функционирует программа подходящего типа, но в отношении этой системы, согласно Сирлу, можно явно показать, что она не обладает разумом. Для этого Сирл прибегает к интуиции, а не к доказательству; он как будто говорит нам: "достаточно взглянуть на эту комнату; разве в ней может быть разум?" Но точно такой же довод можно привести и применительно к мозгу — достаточно взглянуть на этот конгломерат клеток (или атомов), работающих вслепую в соответствии с законами биохимии (или физики); разве в нем может быть разум? Почему в куске мозга может быть разум, а в куске печени — нет?

Более того, Сирл, соглашаясь с тем, что материалы, отличные от нейронов, могут в принципе быть носителем разума, ослабляет свои доводы еще больше, по двум причинам: во-первых, нам приходится руководствоваться только интуицией Сирла (или своей собственной), чтобы доказать, что в китайской комнате отсутствует разум, и, во-вторых, даже если мы решим, что в этой комнате нет разума, такой вывод не позволит нам узнать что-либо о том, не будет ли программа, работающая в какой-то другой физической среде (включая компьютер), иметь разум.

Сирл допускает логическую возможность того, что мозг действительно реализует программу искусственного интеллекта традиционного типа, но та же программа, работающая в машине неподходящего типа, не создает разум. Об этом говорит сайт https://intellect.icu . Сирл отрицает то, будто он верит, что "машины не могут иметь разума", скорее он утверждает, что некоторые машины имеют разум, например люди — это биологические машины, обладающие разумом. Но он также оставляет нас в неведении относительно того, какого же типа машины подходят или не подходят под определение понятия разумных машин.

Эксперимент был опубликован в 1980 году в статье «Minds, Brains, and Programs» журнала «The Behavioral and Brain Sciences (англ.)русск.». Еще до публикации эксперимент вызвал полемику, поэтому статья содержала как оригинальный аргумент Серла, так и возражения 27 исследователей в области когнитивных наук, а также ответы Серла на эти возражения. Помимо этого, эксперимент описан в книге 1984 года «Minds, Brains and Science» и в январском выпуске журнала Scientific American 1990 года .

Представим себе изолированную комнату, в которой находится Джон Серл, который не знает ни одного китайского иероглифа. Однако у него есть записанные в книге точные инструкции по манипуляции иероглифами вида «Возьмите такой-то иероглиф из корзинки номер один и поместите его рядом с таким-то иероглифом из корзинки номер два», но в этих инструкциях отсутствует информация о значении этих иероглифов и Серл просто следует этим инструкциям подобно компьютеру.

Наблюдатель, знающий китайские иероглифы, через щель передает в комнату иероглифы с вопросами, а на выходе ожидает получить осознанный ответ. Инструкция же составлена таким образом, что после применения всех шагов к иероглифам вопроса они преобразуются в иероглифы ответа. Фактически инструкция — это подобие компьютерного алгоритма, а Серл исполняет алгоритм так же, как его исполнил бы компьютер .

В такой ситуации наблюдатель может отправить в комнату любой осмысленный вопрос (например, «Какой цвет вам больше всего нравится?») и получить на него осмысленный ответ (например, «Синий»), как при разговоре с человеком, который свободно владеет китайской письменностью. При этом сам Серл не имеет никаких знаний об иероглифах и не может научиться ими пользоваться, поскольку не может узнать значение даже одного символа. Серл не понимает ни изначального вопроса, ни ответа, который сам составил. Наблюдатель, в свою очередь, может быть уверен, что в комнате находится человек, который знает и понимает иероглифы .

Проблема в том, что неясно, что такое «понимать». Сам Джон Серль может ничего не понимать, но система «Китайская комната» в техническом смысле понимает китайский язык и, возможно, делает это намного лучше, чем некоторые китайцы. Если Джон Серль задавался вопросом о наличии некоторого «внутреннего наблюдателя» (которого, к слову, и у нас в голове нет, это обывательская иллюзия), то это к вопросу о понимании не относится. Но мой личный ответ на этот эксперимент еще проще: «Слабой ИИ-системе и не нужно ничего понимать, а что творится внутри Сильного ИскИна мы познать не сможем точно так же, как не можем познать субъективный мир человека от третьего лица»

Таким образом Серл заключает, что хотя такая система и может пройти тест Тьюринга, но при этом никакого понимания языка внутри системы не происходит, а значит тест Тьюринга не является адекватной проверкой мыслительных способностей. Доводы Серла направлены на критику позиции так называемого «сильного» искусственного интеллекта, согласно которой компьютеры с соответствующей программой на самом деле могут понимать естественный язык, а также обладать другими ментальными способностями, свойственными людям. Гипотеза слабого искусственного интеллекта, напротив, говорит лишь о том, что компьютеры способны имитировать ментальные способности человека, поэтому Серла она не интересует.

Формально аргументацию можно представить так:

Второй пункт обосновывается мысленным экспериментом «китайской комнаты». Вывод говорит о том, что запуск такой программы не ведет к пониманию языка. Более общий вывод Серла говорит о том, что любые манипуляции с синтаксическими конструкциями не могут приводить к пониманию .

У этого философского аргумента можно выделить 3 важных предшественника:

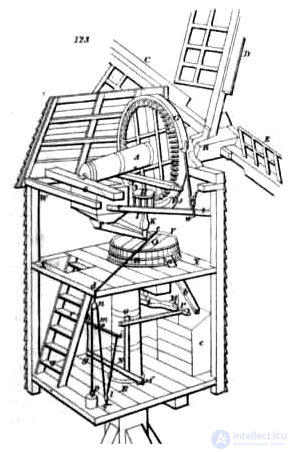

«Мельница Лейбница» — мысленный эксперимент, описанный Готфридом Лейбницем в «Монадологии». Лейбниц предлагает представить машину размером с мельницу, которая симулирует чувства, мысли и восприятие. И если зайти внутрь такой машины, то ни одна из движущихся частей, обеспечивающих ее работу, не будет являться сознанием или объяснением восприятия. Так Лейбниц пытался показать, что одних физических состояний недостаточно для функционирования сознания .

Если мы вообразим себе машину, устройство которой производит мысль, чувство и восприятие, то можно будет представить ее себе в увеличенном виде с сохранением тех же отношений, так что можно будет входить в нее, как в мельницу. Предположив это, мы при осмотре ее не найдем ничего внутри нее, кроме частей, толкающих одна другую, и никогда не найдем ничего такого, чем можно было бы объяснить восприятие.

Этот аргумент Лейбница направлен на отрицание возможности физически объяснить разум и восприятие. В те времена это казалось самим собой разумеющимся, однако сегодня мы не склонны так просто ударяться в мистику и выходить за каузальную замкнутость физического. Несмотря на то, что природа сознания до сих пор нам не поддается, мы в целом уверены, что оно супервентно на фундаментальных физических законах. В общем, чудес не бывает. И, в общем-то, Лейбниц, в целом, был неправ. В этой самой мельнице должно найтись что-то такое, чем можно объяснить восприятие и разум, просто это не механические ее части.

Что в мельнице определяет ее высокоуровневую функцию? Ни один элемент по отдельности либо не предназначен, либо не может превращать зерно в муку, но функция эмерджентно проявляется в системе.

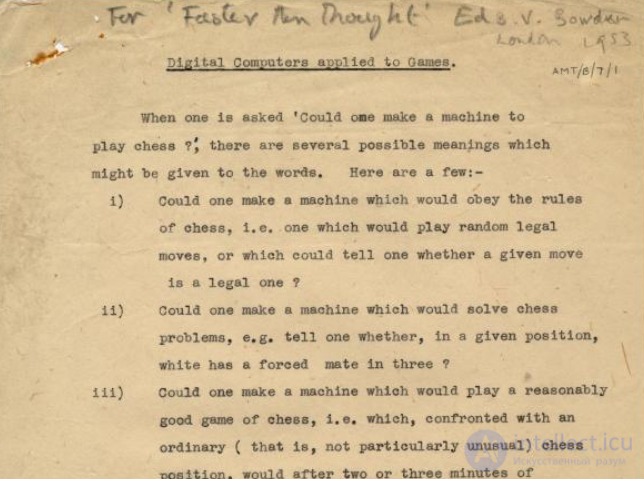

«Бумажная машина Тьюринга» — машинный алгоритм для игры в шахматы, придуманный Аланом Тьюрингом в 1951 году , где в качестве машины-исполнителя выступал человек. При этом человеку не нужно было знать, как играть в шахматы, а нужно было просто исполнять алгоритм, на основе входных данных о ходе соперника (например, «при ходе противника N передвиньте ферзя на B7»). Тьюринг считал, что компьютеры будут способны к поддержанию беседы на человеческом языке, для этого он и разработал то, что сейчас называется тестом Тьюринга .

. В 1951 году Алан Тьюринг написал алгоритм, с помощью которого машина могла бы играть в шахматы, только в роли машины выступал сам изобретатель. Этот нонсенс даже получил название — «бумажная машина Тьюринга». Человеку требовалось более получаса, чтобы сделать один ход. Алгоритм был довольно условный, и сохранилась даже запись партии, где «бумажная машина» Тьюринга проиграла одному из его коллег . Из-за отсутствия доступа к компьютеру программа ни разу не проверялась в работе.

«Китайская нация» — мысленный эксперимент, предложенный Недом Блоком в 1978 году для опровержения функционализма. Эксперимент Блока схож с «Китайской комнатой», однако Блок предлагает использовать множество китайцев, каждый из которых бы эмулировал нейрон искусственного мозга. В такой системе каждый китаец имел бы телефон и список номеров других китайцев. В зависимости от того, когда зазвонил телефон конкретного китайца, он бы звонил кому-либо из своего списка. При этом передача сообщения по телефону не требуется, необходим лишь только факт звонка (так же происходит взаимодействие между нейронами). Тогда, если в такой системе создать функциональное состояние, которое появляется при восприятии боли, вся «Китайская нация» окажется в состоянии боли, при этом ни один из китайцев не будет эту боль чувствовать. Это применимо к любым ментальным состояниям и чувствам

Суть мысленного эксперимента заключается следующем. Раз нам безразличен субстрат, на котором реализуются функциональные и, следовательно, ментальные состояния, то давайте организуем эти состояния при помощи людей. Возьмем довольно большую нацию (например, китайскую, как наиболее многочисленную), и каждому представителю дадим телефон. Телефон может принимать звонок, китаец его обрабатывает и на основе каких-то своих внутренних предпочтений по результатам звонка может позвонить нескольким своим друзьям.

Будучи умудренными, вы уже должны были понять, что китаец представляет собой нейрон, входящий звонок — это входящий импульс на дендрит, исходящий звонок — это исходящий импульс на аксоне. Фактически, при помощи такой «человеческой модели» мы могли бы с точностью симулировать функциональные состояния головного мозга, хотя это было бы медленно. Тем не менее, функции симулировались бы со 100-процентной точностью. Теперь, к примеру, мы звоним одному из этих многочисленных китайцев, который у нас соответствует нейрону, получающему сигнал с ноцицептора, то есть болевого рецептора. Китаец звонит своим друзьям, те своим друзьям и далее по сети. Вопрос: «Где в этой модели возникает субъективное ощущение боли (это и есть один из вариантов ментальных состояний)?» Кто почувствует боль? Ведь ни один из китайцев из-за этого входящего звонка боли не почувствует — это совершенно точно.

Окончательного ответа на поставленный Недом Блоком вопрос нет, как нет ответа на трудную проблему сознания.

Мысленный эксперимент вызвал интенсивную критику в академических кругах. Были выдвинуты различные доводы против аргумента Серла.

Некоторые критики считают, что тест Тьюринга выдержал не человек в комнате, а система, состоящая из комнаты, книги правил и человека. Серл, по их мнению, отвлекает внимание от этого факта, скрывая логические ошибки и концентрируясь на одном из компонентов системы, выполняющем в данном случае чисто механическую работу . Система из книги правил, человека и комнаты, по их мнению, является разумной и понимает китайский язык. В качестве контраргумента Серл предлагает заставить человека запомнить формальные правила ответов для системы. По мнению философа, система, которая теперь будет состоять только из человека, все равно не сможет понять китайский язык .

Часть критиков согласна с тем, что следование простым инструкциям на человеческом языке не создает понимания, однако это не значит, что такое понимание невозможно создать в принципе. Так, например, эти критики полагают, что эффект понимания достижим, если создать робота с самообучающейся программой, а также оснастить его сенсорами для восприятия мира. Такой робот, по их мнению, может взаимодействовать с миром, познавать его и быть способен обучиться подобно ребенку, а следовательно начать понимать так же, как человек. Серл возражал против того, что в случае робота применим тот же аргумент. Серл предлагал поместить человека внутрь робота, и человек, в зависимости от увиденных через сенсоры иероглифов, выполнял бы движение телом робота, и в то же время он бы не имел никакого понимания происходящего, а лишь выполнял синтаксические манипуляции над символами .

Поскольку компьютерные алгоритмы работают не так, как настоящий мозг, некоторые критики предлагают воссоздать нейронную сеть человека, владеющего китайской письменностью. Тогда такая нейронная сеть должна понимать иероглифы точно так же, как и человек. На это Серл возражал, что даже симуляция работы мозга недостаточна для создания эффекта понимания, и предлагал модифицированную «китайскую комнату». В такой комнате вместо нейронов можно представить водопроводные трубы, а человек внутри комнаты переключает эти трубы согласно инструкции в зависимости от входных сигналов. При этом понимания иероглифов не появляется ни у человека, ни у водопроводных труб .

Еще одно возражение к «китайской комнате» основано на том, что мы определяем, понимает ли человек китайские иероглифы, лишь по его поведению. Если компьютер ведет себя так же, как человек, владеющий китайской письменностью, то тогда нам следует полагать, что и компьютер ее понимает. Таким критикам Серл отвечал, что суть аргумента не в том, откуда мы знаем, что у других людей есть ментальные состояния, а в том, что́ есть эти ментальные состояния. С точки зрения Серла, ментальные состояния не могут быть определены как просто вычислительный процесс и его вывод, поскольку для этого не требуется ментальное состояние .

Многие исследователи критиковали Серла за то, что в своих суждениях относительно терминов «понимание» и «сознание» он опирается на интуицию. Однако многие вещи контринтуитивны даже в современной науке, поэтому не следует полагаться на интуицию в суждениях об искусственном интеллекте. В качестве иллюстрации С. Пинкер приводит научно-фантастический очерк, где инопланетяне, имеющие другую форму сознания, прибывают на Землю и не могут поверить, что люди способны что-либо понимать, поскольку внутри их голов находится мясо. По мнению Пинкера, интуиция подводит инопланетян так же, как она подводит Серла . Д. Хофштадтер заявлял также, что автор просто не принимает идею возможности сильного ИИ, настаивая, что тому не будет хватать некой чудодейственной «каузальной силы мозга», которую Серл описывает по-разному и с пробелами в логике .

Серл полагал, что эксперимент с «китайской комнатой» поднимает и более общий философский вопрос соотношения синтаксиса и семантики. По его мнению, в эксперименте не удалось достичь понимания потому, что человек внутри комнаты оперировал лишь синтаксическими конструкциями, в то время как сознание обладает ментальными состояниями, содержащими смысл. Человеческий разум, в отличие от компьютера, воспринимает иероглифы не по тому, как они выглядят, а согласно смыслу, который они содержат. И хотя компьютеры и могут выдавать ответы на естественном языке, они не связывают со словами никакого смысла. Серл считал, что невозможно получить семантические значения лишь из формальных манипуляций символами .

В свою очередь, критики возражали, что компьютерная система, выполняющая программу, тоже имеет сознание. Действительно, алгоритм, записанный в книге и лежащий на книжной полке, не может привести к появлению понимания. Но алгоритм, запущенный на сложной вычислительной машине, имеющий как физическое состояние (вольтаж на транзисторе), так и интерпретацию физического состояния (символы), вполне может давать «эффект» понимания. В качестве пародийного контрпримера к аргументам Серла Д. Чалмерс приводит рецепт кекса, который является чисто синтаксической конструкцией и не приводит к «эффекту» рассыпчатости (аналог «понимания» у Серла), однако кексы являются рассыпчатыми, следовательно, выполнение рецепта недостаточно для появления кекса .

Станислав Лем утверждал, что описанная в эксперименте Серла работа вообще всегда асемантично формальна, следовательно, «понимание» в самих текстах не участвует и тем более «сознание» (в т.ч. в системе «Серл—инструкции»), — тем самым идея доводится до абсурда, не имея отношения к реальной проблематике ИИ .

Еще одним вопросом в дискуссии стала проблема соотношения тела и сознания. По мнению Серла, сознание — это одна из эксклюзивных способностей мозга, основанная на его нейронных процессах. То есть Серл является сторонником теории идентичности в философии сознания .

Сторонники функционализма же, напротив, полагают, что любое ментальное состояние (в том числе сознание) является тем, какие функции оно выполняет. Следовательно, сознание может быть реализовано на любой платформе, которая позволяет выполнить те же функции .

Современные исследования в области нейронауки пока не позволяют сказать, является ли сознание достаточно абстрактной сущностью, чтобы быть абстрагированной от нейронов, или, наоборот, сильно связано с биологической основой функционирования мозга. Этот вопрос остается открытым .

В дискуссии Серл также упирал на разницу между симуляцией и дупликацией. Ведь никто не путает компьютерную симуляцию погоды с реальной погодой. Так, по мнению Серла, и не стоит путать компьютерную симуляцию понимания с реальным пониманием. Однако к этому аргументу высказывались претензии о невозможности отличить симуляцию от дупликации. Например, не ясно, является ли искусственное сердце симуляцией настоящего сердца или дубликатом. То же самое применимо к протезам: люди на протезах ходят или симулируют хождение? Поэтому принцип разделения симуляции и дупликации Серла имеет серьезные проблемы .

Несмотря на длительные дискуссии исследователей из различных областей, спустя более чем 30 лет консенсус относительно аргумента Серла до сих пор не достигнут. Одни называют этот мысленный эксперимент самым известным контрпримером в истории, нанесшим удар по функционализму, от которого тот так и не смог оправиться. Его также называют классическим аргументом для когнитивной науки . Другие (например, Д. Хофштадтер, Д. Деннет, С. Лем) считают этот аргумент явно ошибочным и вводящим в заблуждение .

Если я не полностью рассказал про китайская комната? Напиши в комментариях Надеюсь, что теперь ты понял что такое китайская комната, бумажная машина тьюринга , китайская нация, chinese room, мысленный эксперимент и для чего все это нужно, а если не понял, или есть замечания, то не стесняйся, пиши или спрашивай в комментариях, с удовольствием отвечу. Для того чтобы глубже понять настоятельно рекомендую изучить всю информацию из категории Подходы и направления создания Искусственного интеллекта

Ответы на вопросы для самопроверки пишите в комментариях, мы проверим, или же задавайте свой вопрос по данной теме.

Комментарии

Оставить комментарий

Подходы и направления создания Искусственного интеллекта

Термины: Подходы и направления создания Искусственного интеллекта