Лекция

Это продолжение увлекательной статьи про .

...

необходимо предоставлять новые входные данные, чтобы проверить качество обучения.

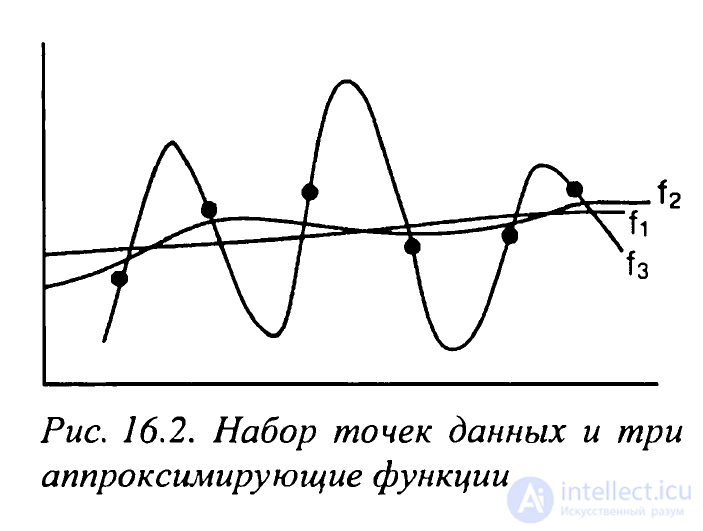

Рис. 16.2. Набор точек данных и три аппроксимирующие функции

Функция f1 представляет довольно точную аппроксимацию методом наименьших квадратов. Дальнейшее обучение системы может дать функцию f2, которая выглядит как достаточно "хорошая" аппроксимация набора данных. Но все же f2 не точно соответствует заданным точкам. Дальнейшее обучение может привести к функциям, которые точно аппроксимируют данные, но дают ужасные обобщения для новых входных данных. Это явление называют переобучением (overtraining) сети. Одной из сильных сторон обучения с обратным распространением ошибки является то, что в предметных областях многих приложений оно дает эффективные обобщения, т.е. аппроксимации функций, которые приближают обучающие данные и корректно обрабатывают новые. Тем не менее обнаружить точку, в которой сеть переходит из "недообученного" в переобученное состояние, - задача нетривиальная. Наивно думать, что можно построить сеть, или вообще какой-либо обучающий инструмент, снабдить его "сырыми" данными, а затем отойти в сторону и наблюдать за тем, как он вырабатывает самые эффективные и полезные обобщения, применимые к новым подобным проблемам.

Подведем итог, возвращая вопрос обобщения в контекст его эпистемологии. Когда решатель задач формирует и применяет обобщения в процессе решения, он создает инварианты или даже системы инвариантов в области задача-решение. Таким образом, качество и четкость таких обобщений могут быть необходимой основой для успешного осуществления проекта. Исследования в области обобщения задачи и процесса ее решения продолжаются.

Индуктивный порог: рационалистское априори

Методы автоматического обучения, рассмотренные в главах 9-11, и, следовательно, большая часть методов ИИ отражают индуктивные пороги, присущие их создателям. Проблема индуктивных порогов в том, что получаемые в результате представления и стратегии поиска дают средство кодирования в уже интерпретированном мире. Они редко могут предоставить механизмы для исследования наших интерпретаций, рождения новых взглядов или отслеживания и изменения неэффективных перспектив. Такие неявные предпосылки приводят к ловушке рационалистской эпистемологии, когда исследуемую среду можно увидеть лишь так, как мы ожидаем или научены ее видеть.

Роль индуктивного порога должна быть явной в каждом обучающем алгоритме. (Альтернативное утверждение гласит, что незнание индуктивного порога вовсе не означает того, что он не существует и не влияет критически на параметры обучения.) В символьном обучении индуктивные пороги обычно очевидны, например, использование семантической сети для концептуального обучения. В обучающем алгоритме Уинстона [Winston, 1975a] пороги включают представление в виде конъюнктивных связей и использование "попаданий близ цели" для коррекции наложенных на систему ограничений. Подобные пороги используются при реализации поиска в пространстве версий (раздел 9.1), построении деревьев решений в алгоритме ID3 (раздел 9.3) или даже правилах Meta-DENDRAL (раздел 9.5).

Как упоминалось в главах 10 и 11, многие аспекты стратегий коннекционистского и генетического обучения также предполагают наличие индуктивных порогов. Например, ограничения персептронных сетей привели к появлению скрытых слоев. Уместен вопрос о том, какой вклад вносят скрытые узлы в получение решения. Одна из функций скрытых узлов состоит в том, что они добавляют новые измерения в пространство представлений. На простом примере из подраздела 10.3.3 было видно, что данные в задаче "исключающего ИЛИ" не были линейно разделимы в двухмерном пространстве. Однако получаемые в процессе обучения весовые коэффициенты добавляют к представлению еще одно измерение. В трехмерном пространстве точки можно разделить двухмерной плоскостью. Выходной слой этой сети можно рассматривать как персептрон, находящий плоскость в трехмерном пространстве.

Стоит отметить, что многие из "различных" парадигм обучения используют (иногда неявно) общие индуктивные пороги. Примером подобной ситуации является взаимосвязь между кластеризацией в системе CLUSTER/2 (раздел 9.5), персептроном (раздел 10.2) и сетями прототипов (раздел 10.3). Было отмечено, что встречное распространение информации в дуальной сети, использующей обучение без учителя с коррекцией весов по выходу в слое Кохонена наряду с обучением с учителем в слое Гроссберга, во многом подобно обучению с обратным распространением ошибки.

Рассмотренные средства схожи во многих важных аспектах. Фактически даже задача кластеризации данных является дополнением к методу аппроксимации функций. В первом случае мы пытаемся классифицировать наборы данных; во втором строим функции, которые однозначно отделяют кластеры данных друг от друга. Это можно наблюдать, когда используемый персептроном алгоритм классификации на основе минимального расстояния находит также параметры, задающие линейное разделение.

Даже задачи обобщения или построения функций можно рассматривать с различных позиций. Например, статистические методы используются для обнаружения корреляции данных. Итеративный вариант рядов Тейлора позволяет аппроксимировать большинство функций. Алгоритмы полиномиальной аппроксимации на протяжении более столетия используются для аппроксимации функций по заданным точкам.

Итак, результат обучения (символьного, коннекционистского или эволюционного) во многом определяется принятыми предположениями о характере решения. Принимая в расчет этот синергетический эффект в процессе разработки вычислительных решателей задач, зачастую можно улучшить шансы на успех и более осмысленно интерпретировать результаты.

Если в сегодняшних подходах к машинному обучению, особенно обучению с учителем, главную роль играет индуктивный порог, то обучение без учителя, которое используется во многих генетических и эволюционных подходах, сталкивается с противоположной проблемой, которую иногда называют дилеммой эмпирика. В таких подходах считается, что решения сложатся сами на основе эволюционирующих альтернатив, в процессе "выживания" наиболее подходящих особей популяции. Это мощный метод, особенно в контексте параллельных и распределенных средств поиска. Но возникает вопрос: откуда можно узнать, что система пришла к правильному решению, если мы не знали, куда идем?

Давным-давно Платон сформулировал эту проблему словами Менона из знаменитого диалога:

"Но каким же образом, Сократ, ты будешь искать вещь, не зная даже, что она такое? Какую из неизвестных тебе вещей изберешь ты предметом исследования? Или, если в лучшем случае ты даже натолкнешься на нее, откуда ты узнаешь, что она именно то, чего ты не знал?"

Несколько исследователей подтверждают слова Менона [Mitchell, 1997] и теорему "о бесплатном сыре" Вольперта и Макреди [Wolpert, Macready, 1995]. Эмпирик фактически нуждается в какой-то доле рационалистского априорного знания для придания научности своим рассуждениям.

Тем не менее продолжается множество увлекательных разработок в обучении без учителя и эволюционном обучении. Примером служит создание сетей, основанных на моделях или минимизации энергии, которые можно рассматривать в качестве аттракторов для сложных инвариантностей. Наблюдая, как данные "выстраиваются" к точкам притяжения, исследователь начинает рассматривать эти архитектуры как средства моделирования динамических явлений. Возникает вопрос: каковы ограничения этих методов?

Фактически исследователи показали [Siegelman и Sontag, 1991], что рекуррентные сети полны в смысле вычислений, т.е. эквивалентны классу машин Тьюринга. Эта эквивалентность обобщает более ранние результаты. Колмогоров [Kolmogorov, 1957] показал, что для каждой непрерывной функции существует нейронная сеть, реализующая ее вычисление. Также было показано, что сеть обратного распространения ошибки с одним скрытым слоем может аппроксимировать любую непрерывную на компакте функцию [Necht-Nielsen, 1989]. В разделе 11.3 было указано, что фон Нейман построил полные, по Тьюрингу, конечные автоматы. Таким образом, сети связей и конечные автоматы оказались еще двумя классами алгоритмов, способных аппроксимировать практически любую функцию. Кроме того, индуктивные пороги применимы к обучению без учителя, а также к эволюционным моделям; пороги представлений применимы к построению узлов, сетей и геномов, а алгоритмические пороги - к механизмам поиска, подкрепления и селекции.

Что в таком случае могут нам предложить коннекционистские, генетические или эволюционные конечные автоматы в их разнообразных формах?

Одна из наиболее привлекательных черт нейросетевого обучения - это возможность адаптации на основе входных данных или примеров. Таким образом, хотя их архитектуры точно проектируются, они обучаются на примерах, обобщая данные в конкретной предметной области. Но возникает вопрос о том, хватает ли данных и достаточно они ли "чисты", чтобы не исказить результат решения. И может ли это знать конструктор?

Генетические алгоритмы также обеспечивают мощный и гибкий механизм поиска в пространстве параметров задачи. Генетический поиск управляется как мутациями, так и специальными операторами (например, скрещивания или инверсии), которые сохраняют важные аспекты родительской информации для последующих поколений. Каким образом проектировщик программы может найти и сохранить в нужной мере компромисс между разнообразием и постоянством?

Генетические алгоритмы и коннекционистские архитектуры можно рассматривать как примеры параллельной и асинхронной обработки. Но действительно ли они обеспечивают результаты, недостижимые в последовательном программировании?

Хотя нейросетевые и социологические корни не имеют принципиального значения для многих современных практиков коннекционистского и генетического обучения, эти методы отражают многие важные стороны естественного отбора и эволюции. В главе 10 были рассмотрены модели обучения с уменьшением ошибки- персептронные сети, сети с обратным распространением ошибки и модели Хебба. В подразделе 10.3.4 описаны сети Хопфилда, предназначенные для решения задач ассоциативной памяти. Разнообразные эволюционные модели рассматривались в главе 11.

И, наконец, все методики обучения являются эмпирическими средствами. Достаточно ли мощны и выразительны эти средства, чтобы по мере выявления инвариантностей нашего мира ставить дальнейшие вопросы о природе восприятия, обучения и понимания?

В следующем разделе будет обоснован вывод о том, что конструктивистская эпистемология, объединенная с экспериментальными методами современного искусственного интеллекта, предлагает средства и технологии для дальнейшего построения и исследования теории интеллектуальных систем.

Теории, как сети: кто их закидывает, у того и улов... - Л. Виттгенштейн (L. Wittgenstein)

Конструктивисты выдвигают гипотезу о том, что всякое понимание является результатом взаимодействия между энергетическими образами мира и ментальными категориями, наложенными на мир разумным агентом [Piaget, 1954, 1970], [von Glasesfeld, 1978]. В терминах Пиаже (Piaget), мы ассимилируем (assimilate) явления внешней среды в соответствии с нашим текущим пониманием и приспосабливаем (accommodate) наше понимание к "требованиям" явления.

Конструктивисты часто используют термин схемы (schemata) для обозначения априорных структур, используемых в организации опытного знания о внешнем мире. Этот термин заимствован у британского психолога Бартлетта [Bartlett, 1932] и корнями уходит в философию Канта. С этой точки зрения наблюдение не пассивно и нейтрально, а является активным и интерпретирующим.

Воспринятая информация (кантовское апостериорное знание) никогда не вписывается точно в заранее составленные схемы. Поэтому пороги, основанные на схемах и используемые субъектом для организации опытных знаний, должны быть модифицированы, расширены или же заменены. Необходимость приспособления, вызванная неудачными взаимодействиями с окружающей средой, служит двигателем процесса когнитивного уравновешивания. Таким образом, конструктивистская эпистемология является основой когнитивной эволюции и уточнения. Важным следствием теории конструктивизма является то, что интерпретация любой ситуации подразумевает применение понятий и категорий наблюдателя.

Когда Пиаже [Piaget, 1954, 1970] предложил конструктивистский подход к пониманию, он назвал его генетической эпистемологией (genetic epistemology). Несоответствие между схемой и реальным миром создает когнитивное противоречие, которое вынуждает пересматривать схему. Исправление схемы, приспособление приводит к непрерывному развитию понимания в сторону равновесия (equilibration).

Пересмотр схемы и движение к равновесию - это врожденная предрасположенность, а также средство приспособления к устройству общества и окружающего мира. В пересмотре схем объединяются обе эти силы, отражающие присущую нам склонность к выживанию. Модификация схем априори запрограммирована нашей генетикой и в то же время является апостериорной функцией общества и мира. Это результат нашего воплощения в пространстве и времени.

Здесь наблюдается слияние эмпирической и рационалистической традиций. Как материализованный объект человек может воспринимать не больше, чем воспринимают его органы чувств. Благодаря приспособлению он выживает, изучая общие принципы внешнего мира. Восприятие определяется нашими ожиданиями, которые, в свою очередь, формируются восприятием. Следовательно, эти функции могут быть поняты лишь в терминах друг друга.

Наконец, человек редко осознает схемы, обеспечивающие его взаимодействие с миром. Он является источником предвзятости и предубеждений в науке и в обществе. Но чаще всего человек не знает их смысла. Они формируются за счет достижения когнитивного равновесия с миром, а не в процессе сознательного мышления.

Почему конструктивистская эпистемология особенно полезна при изучении проблем искусственного интеллекта? Автор считает, что конструктивизм помогает в рассмотрении проблемы эпистемологического доступа (epistemological access). Более столетия в психологии идет борьба между двумя направлениями: позитивистами, которые предлагают исследовать феномен разума, отталкиваясь от обозримого физического поведения, и сторонниками более феноменологического подхода, который позволяет использовать описания от первых лиц. Это разногласие существует, поскольку оба подхода требуют некоторых предположений или толкований. По сравнению с физическими объектами, которые считаются непосредственно наблюдаемыми, умственные состояния и поведение субъекта четко охарактеризовать крайне сложно. Автор полагает, что противоречие между прямым подходом к физическим явлениям и непрямым к ментальным является иллюзорным. Конструктивистский анализ показывает, что никакое опытное знание о предмете не возможно без применения некоторых схем для организации этого опыта. В научных исследованиях это подразумевает, что всякий доступ к явлениям мира происходит посредством построения моделей, приближений и уточнений.

Символьные рассуждения, нейросетевые вычисления и разнообразные формы эволюционных стратегий являются главенствующими подходами в современном изучении ИИ. Тем не менее, как было отмечено в предыдущем разделе, для обеспечения более высокой эффективности эти подходы должны принимать в расчет ограничения мира, согласно которым весь "интеллект" является овеществленным.

Теории внедренного и овеществленного действия утверждают, что интеллект не является результатом управления моделями, построенными разумом. Его лучше всего рассматривать в терминах действий, предпринимаемых помещенным в мир агентом. В качестве метафоры для лучшего понимания разницы между двумя подходами в работе [Suchman, 1987] предлагается сравнение между европейскими методами навигации и менее формальными методами, практикуемыми полинезийскими островитянами. Европейские навигационные методы требуют постоянного отслеживания местонахождения корабля в каждый момент путешествия. Для этого штурманы полагаются на обширные, детальные географические модели. Полинезийские навигаторы, напротив, не пользуются картами и другими средствами определения своего местонахождения. Они используют звезды, ветры и течения, чтобы продолжать движение к своей цели, импровизируя маршрут, который непосредственно зависит от обстоятельств их путешествия. Не полагаясь на модели мира, островитяне рассчитывают на свое взаимодействие с ним и достигают своей цели с помощью надежного и гибкого метода.

Теории внедренного действия утверждают, что интеллект не нужно рассматривать как процесс построения и использования моделей мира. Это, скорее, менее структурированный процесс выполнения действий в этом мире и реагирования на результат. Этот подход акцентирует внимание на способности чувственного восприятия окружающего мира, целенаправленных действиях, а также непрерывной и быстрой реакции на изменения, происходящие в нем. В этом подходе чувства, посредством которых человек внедряется в этот мир, имеют большее значение, нежели процессы рассуждения о них. Важнее способность действовать, а не способность объяснять эти действия.

Влияние такой точки зрения на сети связей и агентские подходы очевидно. Оно состоит в отказе от общих символьных методов в пользу процессов адаптации и обучения.

Работы в области искусственной жизни [Langton, 1995], должно быть, самый яркий пример исследований, выполненных под влиянием теорий внедренного действия. Эти модели разума повлияли на подход к робототехнике Родни Брукса [Brooks, 1989], Брендана Мак-Гонигла [McGonigle, 1998], Льюиса и Люгера [Lewis и Luger, 2000]. Эти исследователи утверждают, что было ошибкой начинать работы в сфере ИИ с реализации высокоуровневых процессов рассуждений в моделируемом разуме. Этот акцент на логических рассуждениях повел человечество неверной дорогой, отвлек внимание от фундаментальных процессов, которые позволяют агенту внедряться в мир и действовать в нем продуктивным образом. По мнению Брукса, нужно начинать с проектирования и исследования небольших простых роботов, созданий, действующих на уровне насекомых. Они позволят изучить процессы, лежащие в основе поведения как простых, так и сложных существ. Построив множество таких простых роботов, Брукс и его коллеги пытаются применить приобретенный опыт в конструировании более сложного робота COG, который, как надеются разработчики, достигнет способностей человека.

Несмотря на это, теория внедренного действия также повлияла на символьные подходы к ИИ. Например, работы в области реактивного планирования [Benson, 1995], [Benson и Nilsson, 1995], [Klein и др., 2000] отвергают традиционные методы планирования, предполагающие разработку полного и определенного плана, который проведет агента по всему пути, от стартовой точки и до желаемой цели. Такие планы редко срабатывают нужным образом, потому что на пути может возникнуть слишком много ошибок и непредвиденных проблем. Напротив, системы реактивного планирования работают циклами. За построением частичного плана следует его выполнение, а затем ситуации переоценивается для построения нового плана.

Конструктивистские теории и теории внедренного действия подтверждают многие идеи философии экзистенциализма. Экзистенциалисты считают, что человек проявляет себя посредством своих действий в окружающем мире. То, во что люди верят (или утверждают, что верят), куда менее важно, чем то, что они совершают в критических ситуациях. Этот акцент весьма важен в ИИ. Исследователи постепенно поняли, что интеллектуальные программы необходимо помещать прямо в предметную область, а не лелеять в лаборатории. В этом причина роста интереса к робототехнике и проблеме восприятия, а также к сети Internet. В последнее время ведутся активные работы по созданию Web-агентов, или "софтботов", - программ, которые выходят в сеть и совершают полезные интеллектуальные действия. Сеть привлекательна для разработчиков ИИ прежде всего тем, что она может предложить интеллектуальным программам мир, куда более сложный, чем построенный в лаборатории. Этот мир, сравнимый по сложности с природой и обществом, могут населять интеллектуальные агенты, не имеющие тел, но способные чувствовать и действовать, как в физическом мире.

По мнению автора, теории внедренного действия будут оказывать все возрастающее влияние на искусственный интеллект, заставляя исследователей уделять больше внимания таким вопросам, как важность овеществления и обоснования для интеллектуального агента. Важно также учитывать влияние социального, культурного и экономического факторов на обучение и на способ влияния мира на рост и эволюцию внедренного агента. [Clark, 1997], [Lakoff и Johnson, 1999].

В заключение сформулируем основные вопросы, которые как способствуют, так и препятствуют сегодняшним усилиям специалистов в построении теории интеллектуальных систем.

Как геометр, напрягший все старанья,

Чтобы измерить круг, схватить умом

Искомого не может основанья,

Таков был я при новом диве том...- Данте (Dante), Рай

Хотя использование методик ИИ для решения практических задач продемонстрировало его полезность, проблема их применения для построения полной теории интеллекта сложна, и работа над ней продолжается. В этом заключительном разделе мы вернемся к вопросам, которые привели автора к изучению проблем искусственного интеллекта и написанию этой книги: возможно ли дать формальное математическое описание процессов, формирующих интеллект?

Вычислительное описание интеллекта возникло с появлением абстрактных определений вычислительных устройств. В 1930-1950-х гг. эту проблему начали исследовать Тьюринг, Пост, Марков и Черч - все они работали над формальными системами для описания вычислений. Целью этого исследования было не просто определить, что подразумевать под вычислениями, но и установить рамки их применимости. Наиболее изученным формальным описанием является универсальная машина Тьюринга [Turing, 1950], хотя правила вывода Поста, лежащие в основе продукционных систем, тоже вносят важный вклад в развитие этой области знаний. Модель Черча [Church, 1941], основанная на частично рекурсивных функциях, привела к созданию современных высокоуровневых функциональных языков, таких как Scheme и Standard ML.

Теоретики доказали, что все эти формализмы эквивалентны по своей мощности: любая функция, вычисляемая при одном подходе, вычисляется и при остальных. На самом деле можно показать, что универсальная машина Тьюринга эквивалента любому современному вычислительному устройству. Исходя из этих фактов, был выдвинут тезис Черча-Тьюринга о том, что невозможно создать модель вычислительного устройства, более мощного, чем уже известные модели. Установив эквивалентность вычислительных моделей, мы обретаем свободу в выборе средств их технической реализации: можно строить машины на основе электронных ламп, кремния, протоплазмы или консервных банок. Автоматизированное проектирование в одной реализации можно рассматривать как эквивалент других механизмов. Это делает еще более важным эмпирический метод, поскольку исследователь может экспериментировать над системой, реализованной одними средствами, чтобы понять систему, реализованную иными.

Хотя, возможно, универсальная машина Тьюринга и Поста чересчур универсальна. Парадокс состоит в том, что для реализации интеллекта может потребоваться менее мощный вычислительный механизм с большим упором на управление. В работе [Levesque и Brachman, 1985] высказано предположение, что для реализации человеческого интеллекта могут потребоваться вычислительно более эффективные (хотя и менее впечатляющие) представления, в том числе основанные на использовании хорновских дизъюнктов для представления рассуждений и сужении фактического знания до основных литералов. Агентские и эволюционные модели интеллекта также разделяют подобную идеологию.

Еще один аспект, связанный с формальной эквивалентностью вычислительных моделей, - это вопрос дуализма, или проблема взаимоотношения мозга и тела. По крайней мере со времен Декарта (см. раздел 1.1) философы задавались вопросом взаимодействия и интеграции мозга, сознания и физического тела. Философы предлагали всевозможные объяснения, от полного материализма до отрицания материального существования, вплоть до вмешательства бога. ИИ и когнитологические исследования отвергают картезианский дуализм в пользу материальной модели разума, основанной на физической реализации, или конкретизации символов, формальном описании вычислительных операций над этими символами, эквивалентности представлений и "реализации" знаний и опыта в овеществленных моделях. Успех таких исследований свидетельствует о справедливости выбранной модели [Johnson-Laird, 1998], [Dennett, 1987], [Luger, 1994].

Тем не менее возникает множество вопросов, связанных с эпистемологическими принципами организации интеллекта как физической системы. Отметим некоторые важные проблемы.

1. Проблема представления. Ньюэлл и Саймон выдвинули гипотезу о том, что физическая символьная система и поиск являются необходимой и достаточной характеристикой интеллекта (см. раздел 16.1). Опровергают ли успехи нейронных сетей, генетических и эволюционных подходов к интеллекту гипотезу о физической символьной системе, или же они сами являются символьными системами?

Вывод о том, что физическая символьная система представляет собой достаточную модель интеллекта, привел ко многим впечатляющим и полезным результатам в современной науке о мышлении. Исследования показали, что можно реализовать физическую символьную систему, которая будет проявлять разумное поведение. Достаточность гипотезы позволяет строить и тестировать символьные модели многих аспектов поведения человека ([Pylyshyn, 1984], [Posner, 1989]). Но теория о том, что физическая символьная система и поиск необходимы для разумного поведения, остается под вопросом [Searle, 1980], [Weizenbaum, 1976], [Winograd и Flores, 1986], [Dreyfus и Dreyfus, 1985], [Penrose, 1989].

2. Роль овеществления в познании. Одним из главных предположений гипотезы о физической символьной системе является то, что физическая реализация символьной системы не влияет на ее функционирование. Значение имеет лишь формальная структура. Это ставится под сомнение многими исследователями [Searle, 1980], [Johnson, 1987], [Agre и Chapman, 1987], [Brooks, 1989], [Varela и др., 1993], которые утверждают, что разумные действия в мире требуют физического воплощения, которое позволяет агенту объединяться с миром. Архитектура сегодняшних компьютеров не допускает такой степени внедрения, ограничивая взаимодействие искусственного интеллекта с миром современными устройствами ввода-вывода. Если эти сомнения верны, то реализация машинного разума требует интерфейса, весьма отличного от предлагаемого современными компьютерами.

3. Культура и интеллект. Традиционно упор в ИИ делался на разум отдельного индивида как источник интеллекта. Предполагается, что изучение принципов работы мозга (способов кодирования и манипулирования знаниями) обеспечит полное понимание истоков интеллекта. Но можно утверждать, что знание лучше рассматривать в контексте общества, чем как отдельную структуру.

В теории интеллекта, описанной в [Edelman, 1992], общество само является носителем важных составляющих интеллекта. Возможно, понимание социального контекста знания и человеческого поведения не менее важно для теории интеллекта, чем понимание процессов отдельного разума (мозга).

4. Природа интерпретации. Большинство вычислительных моделей работают с заранее интерпретированной предметной областью, т.е. существует неявная априорная привязка разработчиков к контексту интерпретации. Из-за этой привязки система ограничена в изменении целей, контекстов, представлений по мере решения задачи. Кроме того, сегодня делается слишком мало попыток осветить процесс построения интерпретации человеком.

Позиция Тарскиана (Tarskian), который рассматривает семантическое приспособление как отображение множества символов на множество объектов, безусловно, слишком слаба и не объясняет, например, тот факт, что одна предметная область может иметь разные интерпретации в свете различных практических целей. Лингвисты пытаются устранить ограничения такой семантики, добавляя к ней теорию прагматики [Austin, 1962] (раздел 13.1). К этим вопросам в последнее время часто обращаются исследователи в области анализа связной речи, поскольку здесь важную роль играет применение символов в контексте. Однако проблема гораздо шире - она сводится к изучению преимуществ и недостатков ссылочных средств в целом [Lave, 1988], [Grosz и Sidner, 1990].

В традиции семиотики, основанной Пирсом [Peirse, 1958] и продолженной в работах [Есо, 1976], [Grice, 1975], [Seboek, 1985], принимается более радикальный подход к языку. Здесь символьные выражения рассматриваются в более широком контексте знаков и знаковых интерпретаций. Это предполагает, что значение символа может быть понято лишь в контексте его интерпретации и взаимодействия с окружающей средой.

5. Неопределенность представлений. Гипотеза Андерсона о неопределенности представлений [Anderson, 1978] гласит: принципиально невозможно определить, какая схема представления наилучшим образом аппроксимирует решение задачи человеком в контексте его опыта и навыков. Эта гипотеза основывается на том факте, что всякая схема представления неразрывно связана с большей вычислительной архитектурой и со стратегиями поиска. Детальный анализ человеческого опыта показывает, что иногда невозможно управлять процессом решения в степени, достаточной для определения представления, или же установить представление, которое бы однозначно определяло процесс. Как и принцип неопределенности в физике, где процесс измерения влияет на исследуемое явление, это соображение важно при проектировании моделей интеллекта, но оно, как будет показано ниже, не ограничивает их применимости.

Такие же замечания могут быть адресованы к самой вычислительной модели, где индуктивные пороги символов и поиска в контексте гипотезы Черча-Тьюринга все же накладывают ограничения на систему. Мысль о необходимости построения некой оптимальной схемы представления вполне может оказаться осколком мечты рационалиста, в то время как ученому нужна лишь модель, достаточно качественная для рассмотрения эмпирических вопросов. Доказательством качества модели является ее способность интерпретировать, предсказывать и адаптироваться.

6. Необходимость построения ошибочных вычислительных моделей. Поппер [Popper, 1959] и другие утверждают, что научные теории должны ошибаться. Следовательно, должны существовать обстоятельства, при которых модель не может успешно аппроксимировать явление. Это связано с тем, что для подтверждения правильности модели не достаточно никакого конечного числа подтверждающих экспериментов. Ошибки в существующих теориях стимулируют дальнейшие исследования.

Крайняя общность гипотезы о физической символьной системе, а также агентских и эволюционных моделей интеллекта может привести к тому, что их будет невозможно заставить ошибаться. Следовательно, их применимость в качестве моделей будет ограниченной. Те же замечания можно сделать по поводу предположений феноменологической традиции (п. 7). Некоторые структуры данных ИИ, такие как семантические сети, тоже настолько общи, что ими можно смоделировать практически все, что поддается описанию, или, как в универсальной машине Тьюринга, любую вычислимую функцию. Таким образом, если исследователю ИИ или когнитологу задать вопрос о том, при каких условиях его модель интеллекта не будет работать, он затруднится ответить.

7. Ограничения научного метода. Некоторые исследователи [Winograd и Flores, 1986], [Weizenbaum, 1976] утверждают, что наиболее важные аспекты интеллекта в принципе невозможно смоделировать, а в особенности с помощью символьного представления. Эти аспекты включают обучение, понимание естественного языка и речь. Эти вопросы корнями уходят глубоко в феноменологическую традицию. Например, замечания Винограда (Winograd) и Флореза (Flores) основываются на проблемах, поднятых в феноменологии [Husserl, 1970], [Heidegger, 1962].

Многие положения современной теории ИИ берут начало в работах Карнапа (Carnap), Фреге (Frege), Лейбница (Leibniz), а также Гоббса (Hobbes), Локка (Locke), Юма (Hume) и Аристотеля. В этой традиции утверждается, что интеллектуальные процессы отвечают законам природы и в принципе постижимы.

Хайдеггер (Heidegger) и его последователи представили альтернативный подход к пониманию интеллекта. Для Хайдеггера рефлексивная осведомленность свойственна миру

продолжение следует...

Часть 1 Искусственный интеллект как эмпирическая проблема

Часть 2 16.1.3. Агенты, интеллект и эволюция - Искусственный интеллект как эмпирическая

Часть 3 Дилемма эмпирика - Искусственный интеллект как эмпирическая проблема

Часть 4 - Искусственный интеллект как эмпирическая проблема

Ответы на вопросы для самопроверки пишите в комментариях, мы проверим, или же задавайте свой вопрос по данной теме.

Комментарии

Оставить комментарий

Подходы и направления создания Искусственного интеллекта

Термины: Подходы и направления создания Искусственного интеллекта