Лекция

Привет, сегодня поговорим про неокогнитрон фукушимы , обещаю рассказать все что знаю. Для того чтобы лучше понимать что такое неокогнитрон фукушимы , настоятельно рекомендую прочитать все из категории Computational Neuroscience (вычислительная нейронаука) Теория и приложения искусственных нейронных сетей.

КОГНИТРОН и неокогнитрон фукушимы . Правила обучения. Инвариантное распознавание образов НЕОКОГНИТРОНОМ.

В этой лекции мы переходим к рассмотрению некоторых относительно новых современных архитектур, среди которых прежде всего следует отметить НЕОКОГНИТРОН и его модификации. В следующей лекции будут обсуждаться варианты сетей, построенных на теории адаптивного резонанса (АРТ).

Создание КОГНИТРОНА (K.Fukushima, 1975) явилось плодом синтеза усилий нейрофизиологов и психологов, а также специалистов в области нейрокибернетики, совместно занятых изучением системы восприятия человека. Данная нейронная сеть одновременно является как моделью процессов восприятия на микроуровне, так и вычислительной системой, применяющейся для технических задач распознавания образов.

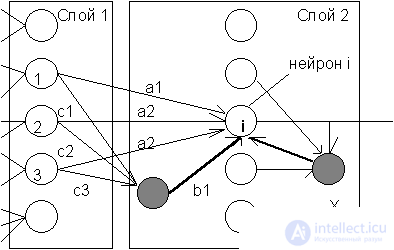

КОГНИТРОН состоит из иерархически связанных слоев нейронов двух типов - тормозящих и возбуждающих. Состояние возбуждения каждого нейрона определяется суммой его тормозящих и возбуждающих входов. Синаптические связи идут от нейронов одного слоя (далее слоя 1) к следующему (слою 2). Относительно данной синаптической связи соотвествующий нейрон слоя 1 является пресинаптическим, а нейрон второго слоя - постсинаптическим. Постсинаптические нейроны связаны не со всеми нейронами 1-го слоя, а лишь с теми, которые принадлежат их локальной области связей. Области связей близких друг к другу постсинаптических нейронов перекрываются, поэтому активность данного пресинаптического нейрона будет сказываться на все более расширяющейся области постсинаптических нейронов следующих слоев иерархии.

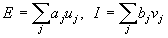

Вход возбуждающего постсинаптического нейрона (на Рис. 10.1 - нейрон i) определяется отношением суммы E его возбуждающих входов (a1, a2 и a3) к сумме I тормозящих входов (b1 и вход от нейрона X):

где u - возбуждающие входы с весами a, v-тормозящие входы с весами b. Все веса имеют положительные значения. По значениям E и I вычисляется суммарное воздействие на i-й нейрон: neti =((1+E)/(1+I))-1 . Его выходная активность uiзатем устанавливается равной neti, если neti > 0. В противном случае выход устанавливается равным нулю. Анализ формулы для суммарного воздействия показывает, что при малом торможении I оно равно разности возбуждающего и тормозящего сигналов. В случае же когда оба эти сигнала велики, воздействие ограничивается отношением. Такие особенности реакции соответствуют реакциям биологических нейронов, способных работать в широком диапазоне воздействий.

Пресинаптические тормозящие нейроны имеют ту же область связей, что и рассматриваемый возбуждающий постсинаптический нейрон i. При этом веса таких тормозящих нейронов (c1, c2 и c3) являются заданными и не изменяются при обучении. Их сумма равна единице, таким образом, выход тормозного пресинаптического нейрона равен средней активности возбуждающих пресинаптических нейронов в области связей:

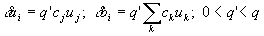

Обучение весов возбуждающих нейронов происходит по принципу "победитель забирает все" в области конкуренции - некоторой окрестности данного возбуждающего нейрона. Об этом говорит сайт https://intellect.icu . На данном шаге модифицируются только веса ai нейрона с максимальным возбуждением:

где cj - тормозящий вес связи нейрона j в первом слое, uj - состояние его возбуждения, q - коэффициент обучения. Веса тормозящего нейрона i второго слоя модифицируются пропорционально отношению суммы возбуждающих входов к сумме тормозящих входов:

В случае, когда победителя в области конкуренции (на слое 2) нет, как это имеет место, например в начале обучения, веса подстраиваются по другим формулам:

Данная процедура обучения приводит к дальнейшему росту возбуждающих связей активных нейронов и торможению пассивных. При этом веса каждого из нейронов в слое 2 настраиваются на некоторый образ, часто пред'являемый при обучении. Новое пред'явление этого образа вызовет высокий уровень возбуждения соответсвующего нейрона, при появлении же других образов, его активность будет малой и будет подавлена при латеральном торможении.

Веса нейрона X, осуществляющего латеральное торможение в области конкуренции, являются немодифицируемыми, их сумма равна единице. При этом во втором слое выполняются итерации, аналогичные конкурентным итерациям в сети Липпмана-Хемминга, рассмотренной нами в 7 лекции.

Отметим, что перекрывающиеся области конкуренции близких нейронов второго слоя содержат относительно небольшое число других нейронов, поэтому конкретный нейрон-победитель не может осуществить торможение всего второго слоя. Следовательно, в конкурентной борьбе могут выиграть несколько нейронов второго слоя, обеспечивая более полную и надежную переработку информации.

В целом КОГНИТРОН представляет собой иерархию слоев, последовательно связанных друг с другом, как было рассмотрено выше для пары слой 1 - слой 2. При этом нейроны слоя образуют не одномерную цепочку, как на Рис. 10.1, а покрывают плоскость, аналогично слоистому строению зрительной коры человека. Каждый слой реализует свой уровень обобщения информации. Входные слои чувствительны к отдельным элементарным структурам, например, линиям определенной ориентации или цвета. Последующие слои реагируют уже на более сложные обобщенные образы. В самом верхнем уровне иерархии активные нейроны определяют результат работы сети - узнавание определенного образа. Для каждого в значительной степени нового образа картинка активности выходного слоя будет уникальной. При этом она сохранится и при пред'явлении искаженной или зашумленной версии этого образа. Таким образом, обработка информации КОГНИТРОНОМ происходит с формированием ассоциаций и обобщений.

Автором КОГНИТРОНА Фукушимой эта сеть применялась для оптического распознавания символов - арабских цифр. В экспериментах использовалась сеть с 4-мя слоями нейронов, упорядоченными в матрицы 12 x 12 с квадратной областью связей каждого нейрона размером 5 x 5 и областью конкуренции в форме ромба с высотой и шириной 5 нейронов. Параметры обучения были равны q=16, q'=2. В результате было получено успешное обучение системы на пяти образах цифр (аналогичных картинкам с буквами, которые мы рассматривали для сети Хопфилда), при этом потребовалось около 20 циклов обучения для каждой картинки.

Несмотря на успешные применения и многочисленные достоинства, как то соответствие нейроструктуры и механизмов обучения биологическим моделям, параллельность и иерархичность обработки информации, распределенность и ассоциативность памяти и др., КОГНИТРОН имеет и свои недостатки. По-видимому, главным из них является не способность этой сети распознавать смещенные или повернутые относительно их исходного положения образы. Так например, две картинки на Рис. 10.2 с точки зрения человека несомненно являются образами одной и той же цифры 5, однако КОГНИТРОН не в состоянии уловить это сходство.

О распознавании образов независимо от их положения, ориентации, а иногда и размера и других деформации, говорят как об инвариантном относительно соотвествующих преобразований распознавании. Дальнейшие исследования группы под руководством К.Фукушимы привели к развитию КОГНИТРОНА и разработке новой нейросетевой парадигмы - НЕОКОГНИТРОНА, который способен к инвариантному распознаванию.

Новая работа Фукушимы была опубликована в 1980 г. НЕОКОГНИТРОН хотя и имеет много общих черт с его прародителем КОГНИТРОНОМ, но одновременно он претерпел значительные изменения и усложнения, в соответствии с появлением новых нейробиологических данных (Hubel D.H., Wiesel T.N., 1977, и др.).

НЕОКОГНИТРОН состоит из иерархии нейронных слоев, каждый из которых состоит из массива плоскостей. Каждый элемент массива состоит из пары плоскостей нейронов. Первая плоскость состоит из так называемых простых нейроклеток, которые получают сигналы от предыдущего слоя и выделяют определенные образы. Эти образы далее обрабатываются сложными нейронами второй плоскости, задачей которых является сделать выделенные образы менее зависимыми от их положения.

Нейроны каждой пары плоскостей обучаются реагировать на определенный образ, представленный в определенной ориентации. Для другого образа или для нового угла поворота образа требуется новая пара плоскостей. Таким образом, при больших об'емах информации, НЕОКОГНИТРОН представляет собой огромную структуру с большим числом плоскостей и слоев нейронов.

Простые нейроны чувствительны к небольшой области входного образа, называемой рецептивной областью (или что тоже самое, областью связей). Простой нейрон приходит в возбужденное состояние, если в его рецептивной области возникает определенный образ. Рецептивные области простых клеток перекрываются и покрывают все изображение. Сложные нейроны получают сигналы от простых клеток, при этом для возбуждения сложного нейрона достаточно одного сигнала от любого простого нейрона. Тем самым, сложная клетка регистрирует определенный образ независимо от того, какой из простых нейронов выполнил детектирование, и, значит, независимо от его расположения.

По мере распространения информации от слоя слою картинка нейронной активности становится все менее чувствительной к ориентации и распололожению образа, и, в определенных пределах, к его размеру. Нейроны выходного слоя выполняют окончательное инвариантное распознавание.

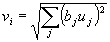

Обучение НЕОКОГНИТРОНА аналогично уже рассмотренному обучению КОГНИТРОНА. При изменяются только синаптические веса простых клеток. Тормозящие нейроны вместо средней активности нейронов в области связей используют квадратный корень из взвешенной суммы квадратов входов:

Такая формула для активности тормозящей клетки менее чувствительна к размеру образа. После выбора простого нейрона, веса которого будут обучаться, он рассматривается в качестве представителя слоя, и веса всех остальных нейронов будут обучаться по тем же правилам. Таким образом, все простые клетки обучаются одинаково, выдавая при распознавании одинаковую реакцию на одинаковые образы.

Для уменьшения об'ема обрабатываемой информации решептивные поля нейронов при переходе со слоя на слой расширяются, а число нейронов уменьшается. В выходном слое на каждой плоскости остается только один нейрон, рецептивное поле которого покрывает все поле образа предыдущего слоя. В целом функционирование НЕОКОГНИТРОНА происходит следующим образом. Копии входного изображения поступают на все плоскости простых клеток первого слоя. Далее все плоскости функционируют параллельно, передавая информацию следующему слою. По достижении выходного слоя, в котором каждая плоскость содержит один нейрон, возникает некоторое окончательное распределение активности. На результат распознавания указывает тот нейрон, активность которого оказалась максимальной. При этом существенно разным входным изображениям будут соответствовать разные результаты распознавания.

НЕОКОГНИТРОН успешно проявил себя при распознавании символов. Нужно отметить, что структура этой сети необычайно сложна, и об'ем вычислений очень велик, поэтому компьютерные модели НЕОКОГНИТРОНА будут слишком дорогими для промышленных приложений. Возможной альтернативой является, конечно, переход на аппаратные или оптические реализации, однако их рассмотрение находится за рамками этой книги.

В общем, мой друг ты одолел чтение этой статьи об неокогнитрон фукушимы . Работы впереди у тебя будет много. Смело пиши комментарии, развивайся и счастье окажется в твоих руках. Надеюсь, что теперь ты понял что такое неокогнитрон фукушимы и для чего все это нужно, а если не понял, или есть замечания, то не стесняйся, пиши или спрашивай в комментариях, с удовольствием отвечу. Для того чтобы глубже понять настоятельно рекомендую изучить всю информацию из категории Computational Neuroscience (вычислительная нейронаука) Теория и приложения искусственных нейронных сетей

Комментарии

Оставить комментарий

Computational Neuroscience (вычислительная нейронаука) Теория и приложения искусственных нейронных сетей

Термины: Computational Neuroscience (вычислительная нейронаука) Теория и приложения искусственных нейронных сетей